Implementazione di VXLAN VPN, in più siti tramite DCNM 11.2(1)

Opzioni per il download

Linguaggio senza pregiudizi

La documentazione per questo prodotto è stata redatta cercando di utilizzare un linguaggio senza pregiudizi. Ai fini di questa documentazione, per linguaggio senza di pregiudizi si intende un linguaggio che non implica discriminazioni basate su età, disabilità, genere, identità razziale, identità etnica, orientamento sessuale, status socioeconomico e intersezionalità. Le eventuali eccezioni possono dipendere dal linguaggio codificato nelle interfacce utente del software del prodotto, dal linguaggio utilizzato nella documentazione RFP o dal linguaggio utilizzato in prodotti di terze parti a cui si fa riferimento. Scopri di più sul modo in cui Cisco utilizza il linguaggio inclusivo.

Informazioni su questa traduzione

Cisco ha tradotto questo documento utilizzando una combinazione di tecnologie automatiche e umane per offrire ai nostri utenti in tutto il mondo contenuti di supporto nella propria lingua. Si noti che anche la migliore traduzione automatica non sarà mai accurata come quella fornita da un traduttore professionista. Cisco Systems, Inc. non si assume alcuna responsabilità per l’accuratezza di queste traduzioni e consiglia di consultare sempre il documento originale in inglese (disponibile al link fornito).

Sommario

Introduzione

In questo documento viene descritto come distribuire due singoli fabric VXLAN EVPN e come unire questi due fabric in un'implementazione di fabric EVPN multisito utilizzando Cisco Data Center Manager (DCNM) 11.2(1).

Multi-Site Domain (MSD), introdotto in DCNM versione 11.0(1), è un contenitore multifabbrico creato per gestire più fabric membro. È un singolo punto di controllo per una definizione di reti overlay e VRF (Virtual Routing and Forwarding) condivise tra fabric membri.

Nota: questo documento non descrive i dettagli relativi alle funzioni/proprietà di ciascuna scheda in DCNM. Consultare la sezione Riferimenti alla fine che fornisce spiegazioni dettagliate.

Prerequisiti

Requisiti

Cisco raccomanda la conoscenza dei seguenti argomenti:

-

vCenter/UCS per distribuire la macchina virtuale DCNM

-

Familiarità con NX-OS e Nexus 9000s

-

Nexus 9000s ToRs, EoRs connesso in modo Leaf/Spine

Componenti usati

Le informazioni fornite in questo documento si basano sui seguenti componenti software e hardware:

- DCNM 11.2(1)

- NX-OS 7.0(3)I7(7) e NX-OS 9.2(3)

- Aculei: N9K-C9508 / N9K-X97160YC-EX e N9K-C9508 / N9K-X9636PQ

- Foglie: N9K-C9372TX, N9K-C93180YC-EX, N9K-C9372TX-E, N9K-C92160YC-X

- Gateway per bordi: N9K-C93240YC-FX2 e N9K-C93180YC-FX

- 7.000 "host": N77-C7709

Le informazioni discusse in questo documento fanno riferimento a dispositivi usati in uno specifico ambiente di emulazione. Su tutti i dispositivi menzionati nel documento la configurazione è stata ripristinata ai valori predefiniti. Se la rete è operativa, valutare attentamente eventuali conseguenze derivanti dall'uso dei comandi.

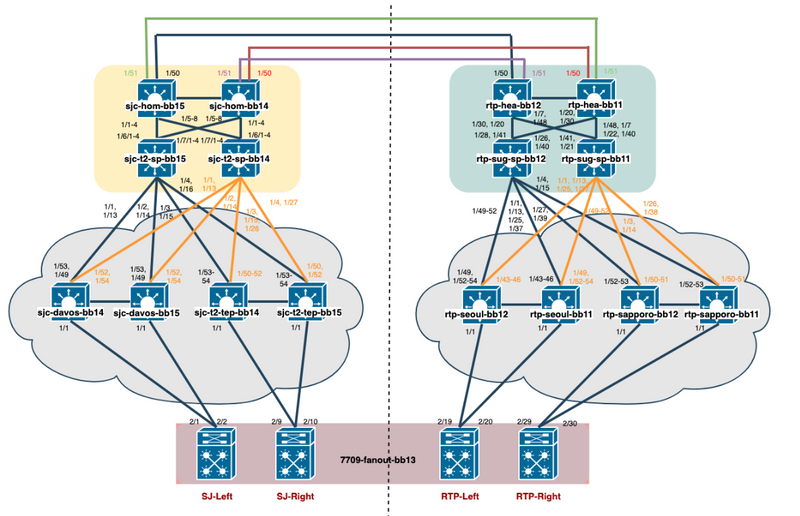

Creazione topologia fisica

Distribuire OVA/OVF in vCenter

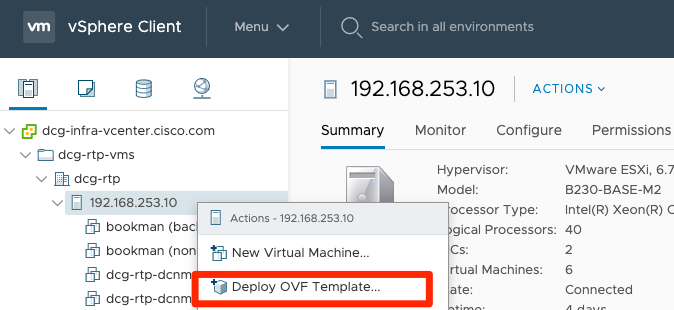

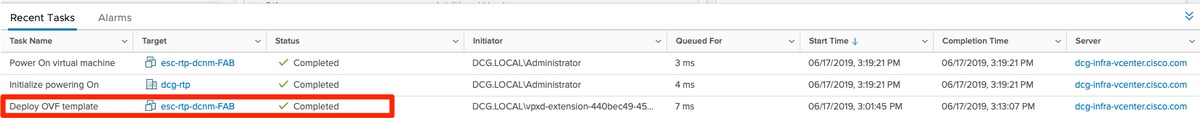

Passaggio 1. In vCenter, distribuire il modello OVF (Open Virtualization Format) nel server/host desiderato, come mostrato nell'immagine.

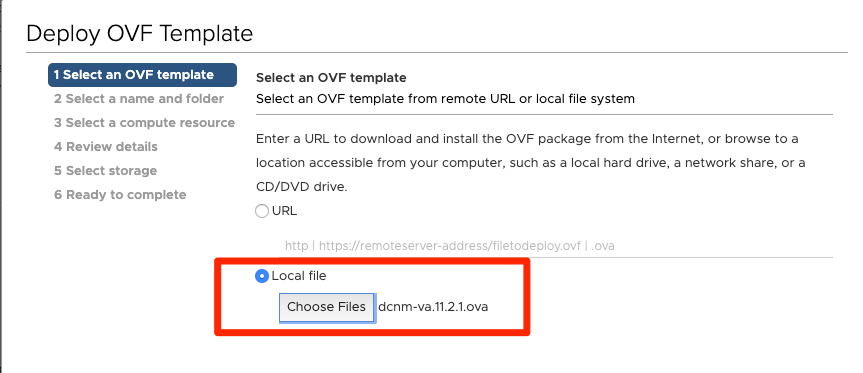

- Disporre localmente di file OVA/OVF, ecc. e selezionare tramite Scegli file, come mostrato nell'immagine:

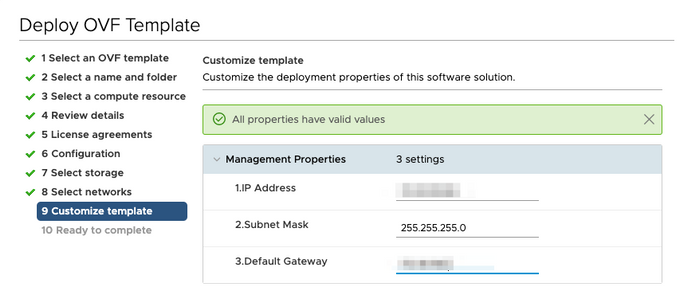

- Seguire il resto dei prompt (nome della macchina virtuale, host, impostazioni di rete, come mostrato nell'immagine) e fare clic su Fine.

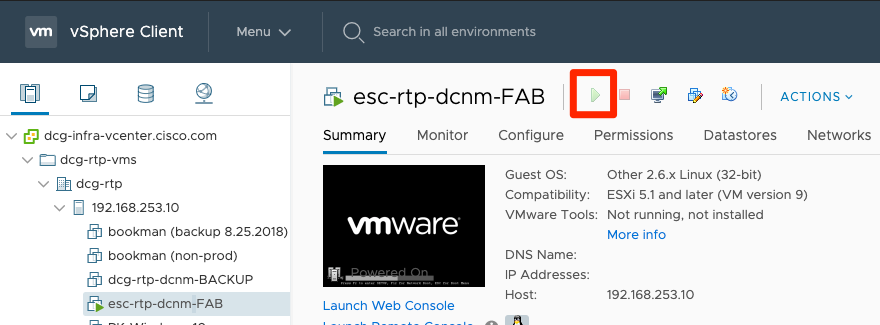

Passaggio 2. Al termine, avviare la macchina virtuale DCNM, come illustrato di seguito.

Passaggio 3. Avviare la console Web, una volta nella console, dovrebbe essere visualizzato questo prompt (l'indirizzo IP varia in quanto è specifico dell'ambiente e della configurazione):

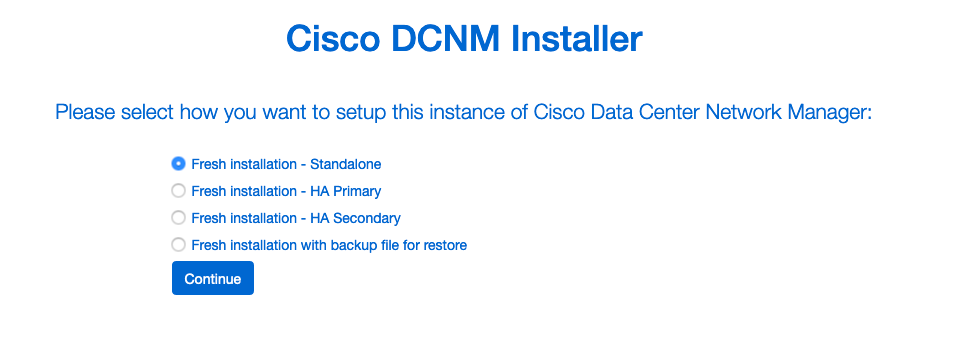

Passaggio 4. Accedere a https://<your IP>:2443 (si tratta dell'indirizzo IP configurato in precedenza durante la distribuzione degli OAV) e fare clic su Get Started. In questo esempio viene illustrata un'installazione Fresh.

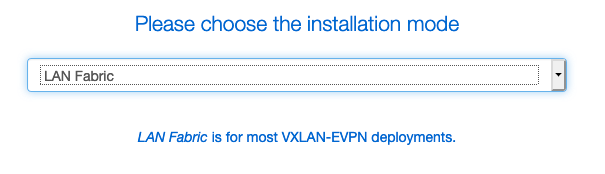

Passaggio 5. Dopo aver configurato la password amministratore, è necessario selezionare il tipo di struttura da installare. Selezionare tra LAN o FAB poiché ogni tipo ha uno scopo diverso, quindi accertarsi di comprendere e scegliere correttamente. Nell'esempio, viene usato LAN Fabric, che è adatto alla maggior parte delle implementazioni VXLAN-EVPN.

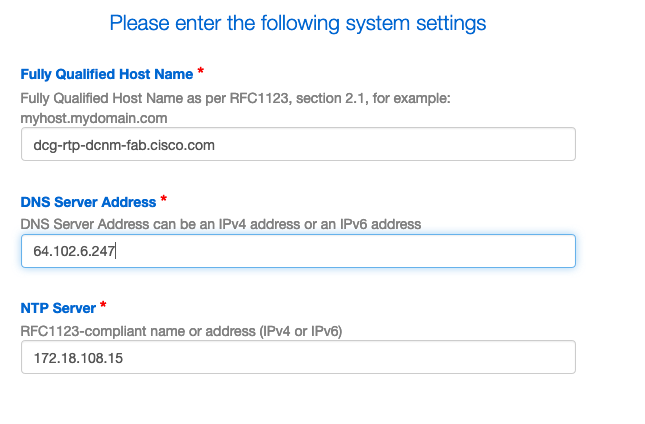

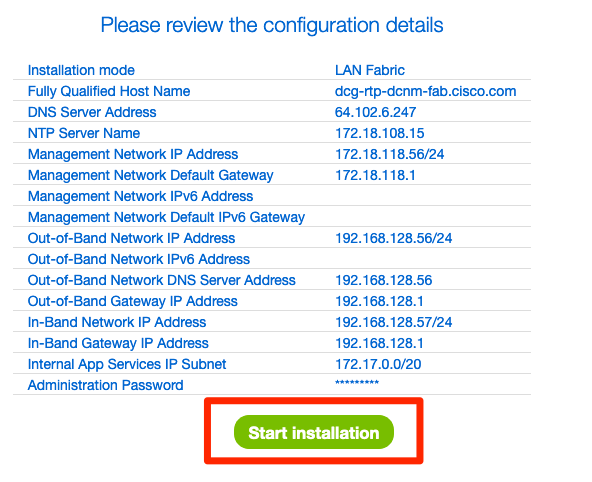

Passaggio 6. Seguire le istruzioni dell'installatore con il DNS della rete, il server NTP (Network Time Protocol), il nome host DCNM, ecc.

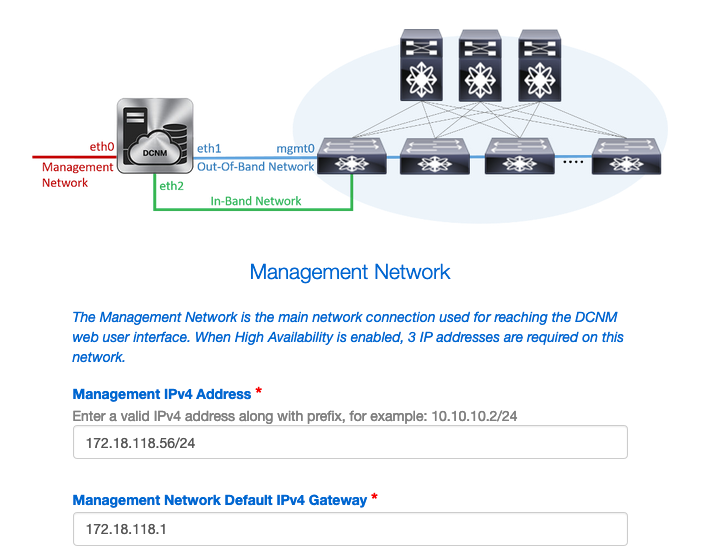

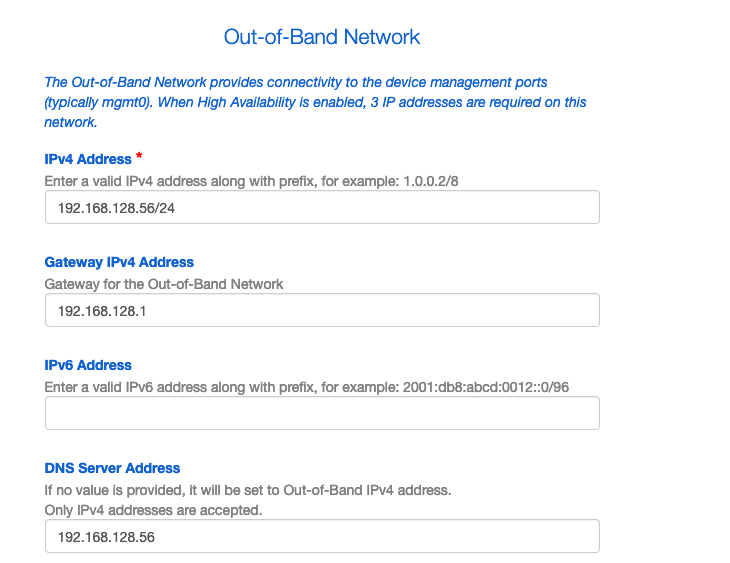

Passaggio 7. Configurare l'IP di gestione e il gateway di gestione. La rete di gestione fornisce connettività (SSH, SCP, HTTP, HTTPS) al server DCNM. Questo è anche l'indirizzo IP usato per raggiungere la GUI. L'indirizzo IP deve essere preconfigurato dall'utente dall'installazione di OVA eseguita in precedenza.

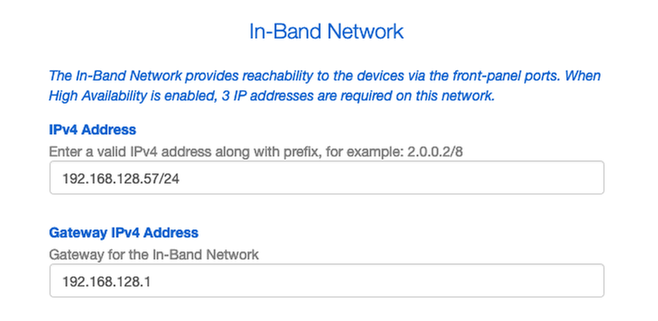

Passaggio 8. Configurare la rete in banda. La rete In-Band viene utilizzata per applicazioni come Endpoint Locator, che richiede la connettività della porta del pannello anteriore ai 9K della struttura per funzionare come sessione BGP (Border Gateway Protocol) stabilita tra DCNM e 9K.

Passaggio 9. Configurare la rete di servizi applicativi interni —

Per iniziare con DCNM versione 11.0, DCNM supporta Application Framework (AFW) con DCNM LAN OVA/ISO Installation. Questa struttura utilizza Docker per orchestrare le applicazioni come microservizi in ambienti cluster e non cluster per realizzare un'architettura con scalabilità orizzontale.

Altre applicazioni fornite per impostazione predefinita con DCNM sono Endpoint Locator, Watch Tower, plug-in Virtual Machine Manager, Config Compliance e così via. AFW si occupa della gestione del ciclo di vita di queste applicazioni, fornendo anche rete, storage, autenticazione, sicurezza, ecc. AFW gestisce inoltre la distribuzione e il ciclo di vita delle applicazioni di Network Insights, ovvero NIR e NIA. Questa subnet è destinata ai servizi Docker quando NIA/NIR è abilitato.

Le modalità di installazione di NIA/NIR sono descritte nella sezione Operazioni del giorno 2.

Nota: Questa subnet non deve sovrapporsi alle reti assegnate alle interfacce eth0/eth1/eth2 assegnate a DCNM e ai nodi di elaborazione. Inoltre, questa subnet non deve sovrapporsi agli IP allocati agli switch o ad altri dispositivi gestiti da DCNM. La subnet scelta deve rimanere coerente durante l'installazione dei nodi primari e secondari DCNM (in caso di distribuzione HA nativa).

Passaggio 10. Esaminare e confermare tutti i dettagli di configurazione e avviare l'installazione.

Passaggio 11. Una volta completata l'installazione di DCNM, accedere alla GUI (indirizzo IP o nome host configurato in precedenza).

Implementazione del primo fabric: fabric RTP

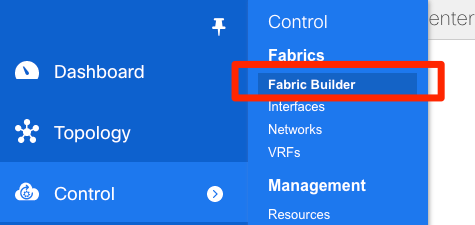

Passaggio 1. Nell'interfaccia utente grafica di DCNM, passare a Fabric Builder. Controllo > Fabric > Fabric Builder per creare il primo fabric.

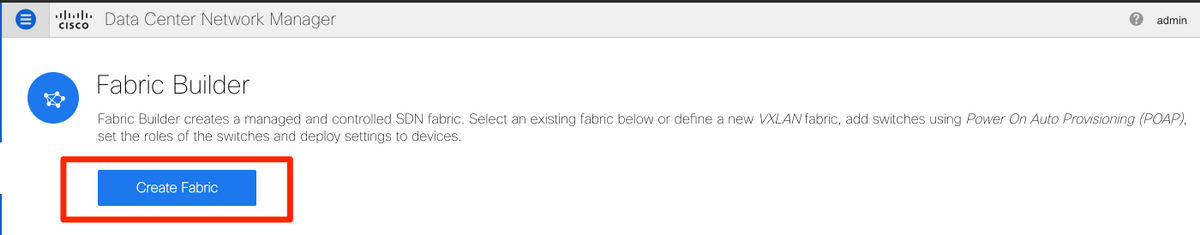

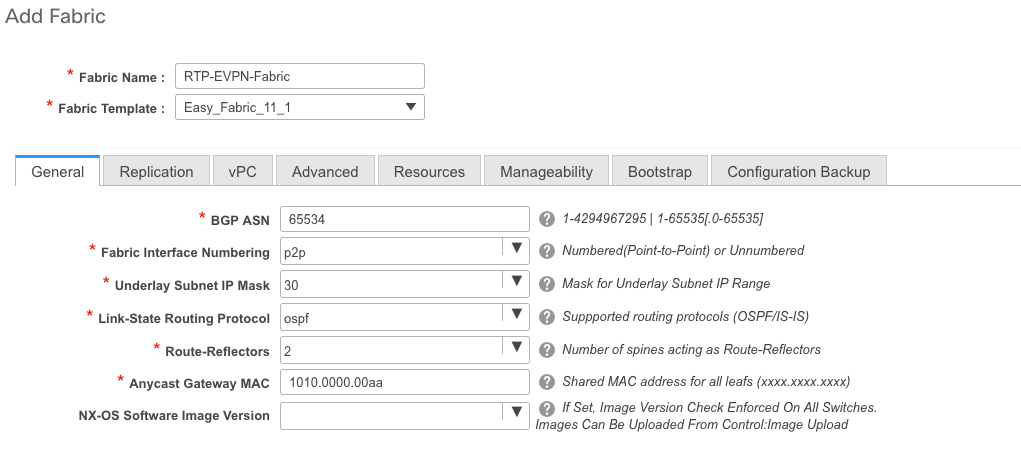

Passaggio 2. Fare clic su Create Fabric e compilare i moduli necessari per la rete. Easy Fabric è il modello corretto per la distribuzione VXLAN EVPN locale:

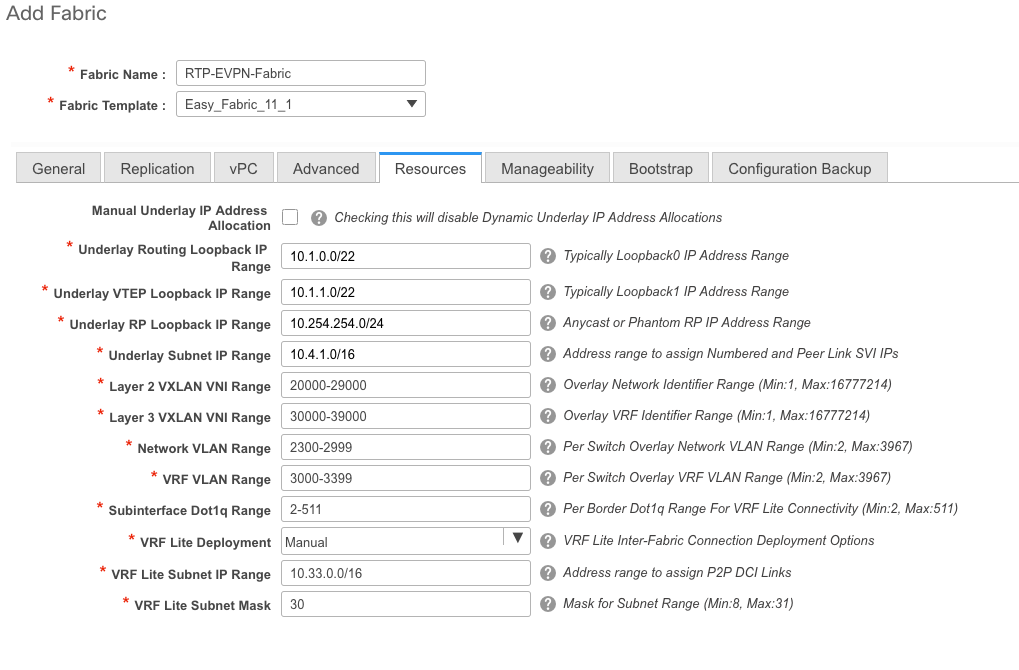

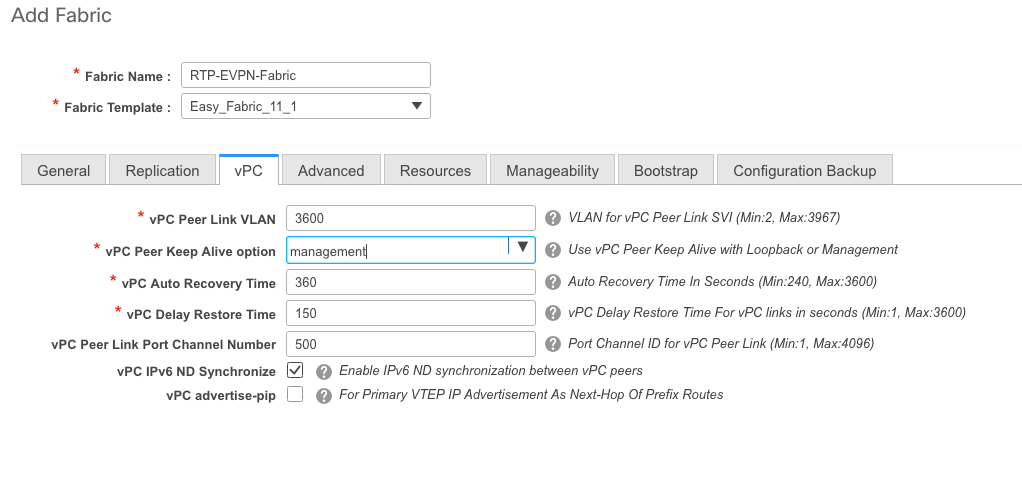

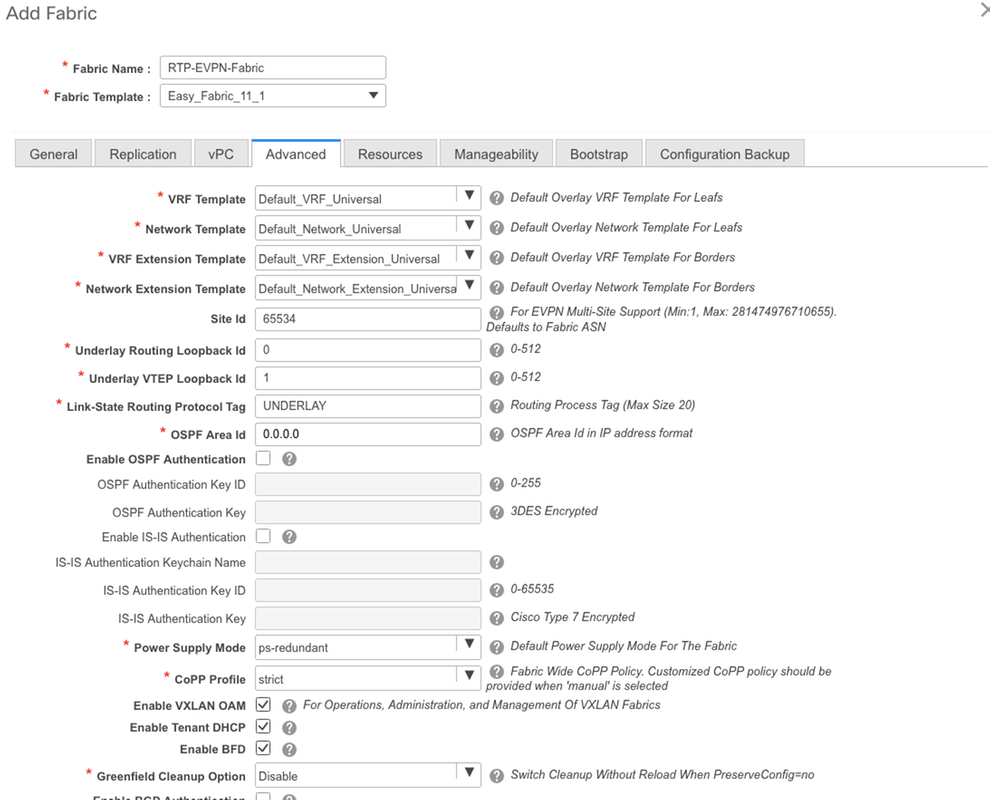

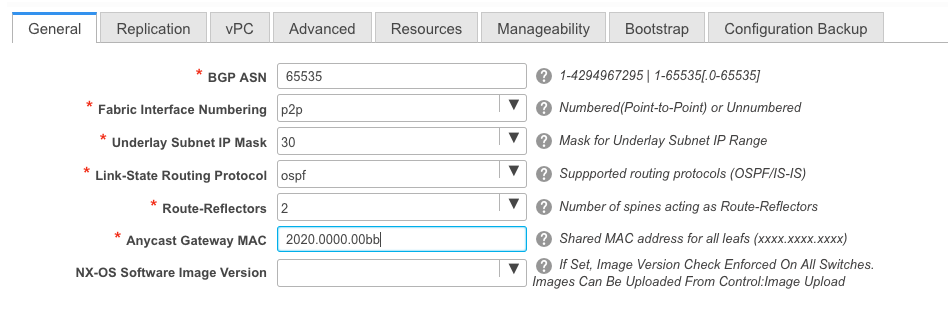

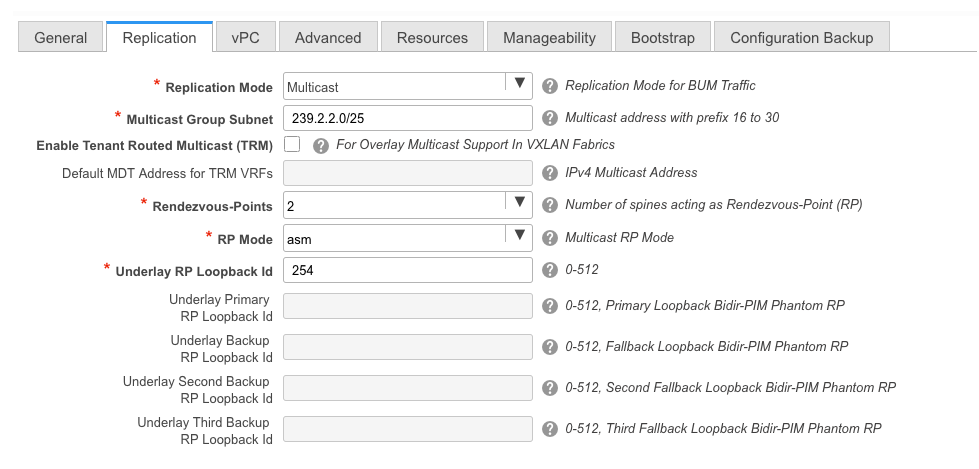

Passaggio 3. Rispondere ai requisiti relativi a struttura, sovrapposizione, vPC, replica, risorse e così via.

In questa sezione vengono descritte tutte le impostazioni di sovrapposizione, sovrapposizione, vPC, replica e così via richieste tramite DCNM. Ciò dipende dallo schema di indirizzamento della rete, dai requisiti, ecc. In questo esempio, la maggior parte dei campi viene lasciata come predefinita. L2VNI e L3VNI sono stati modificati in modo tale che gli L2VNI iniziano con 2 e gli L3VNI iniziano con 3 per facilitare la risoluzione dei problemi in seguito. Insieme ad altre funzioni è abilitato anche il rilevamento dell'inoltro bidirezionale (BFD).

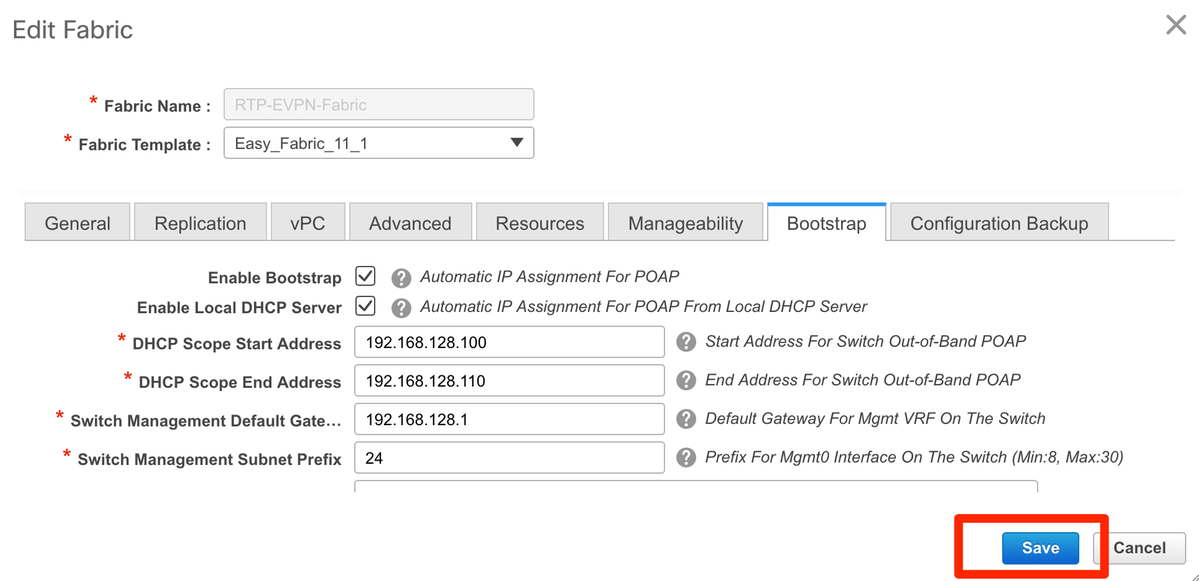

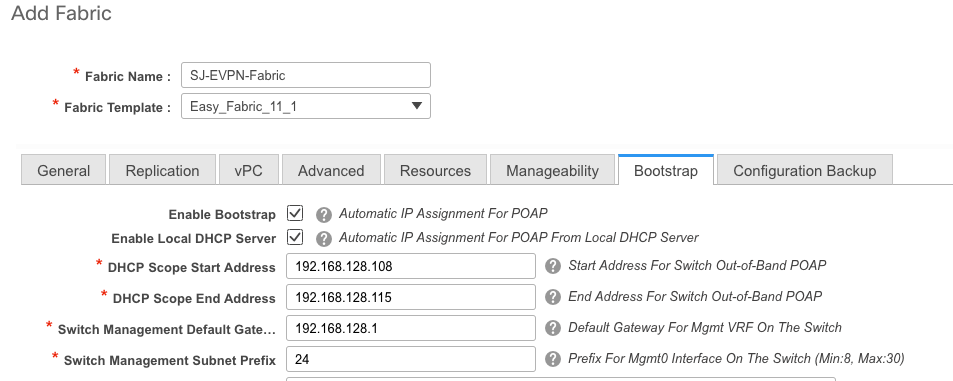

Passaggio 4. In una configurazione bootstrap, configurare l'intervallo di indirizzi DHCP che DCNM deve comunicare agli switch dell'infrastruttura durante il processo POAP. Configurare anche un gateway predefinito corretto (esistente). Al termine, fare clic su Save (Salva) per passare all'aggiunta di switch al fabric.

Aggiunta di switch al fabric

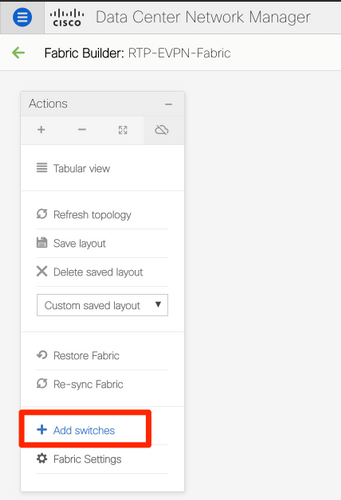

Passaggio 1. Passare a Controllo > Fabric > Fabric Builder, quindi selezionare il fabric. Nel pannello a sinistra, fare clic su Add Switches (Aggiungi switch), come mostrato nell'immagine.

È possibile rilevare gli switch sia utilizzando un valore di inizializzazione IP (ossia l'indirizzo IP mgmt0 di ciascuno switch deve essere configurato manualmente) sia tramite il protocollo POAP e configurare automaticamente con DCNM tutti gli indirizzi IP mgmt0, la gestione VRF, ecc. Per questo esempio verrà utilizzato il protocollo POAP.

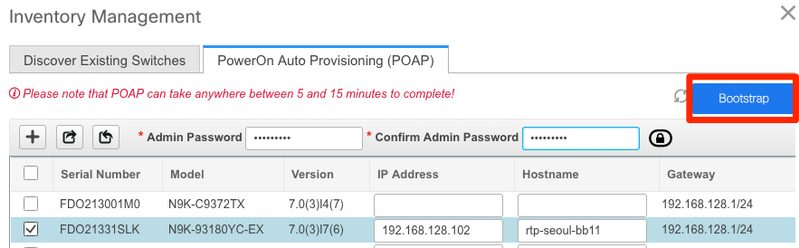

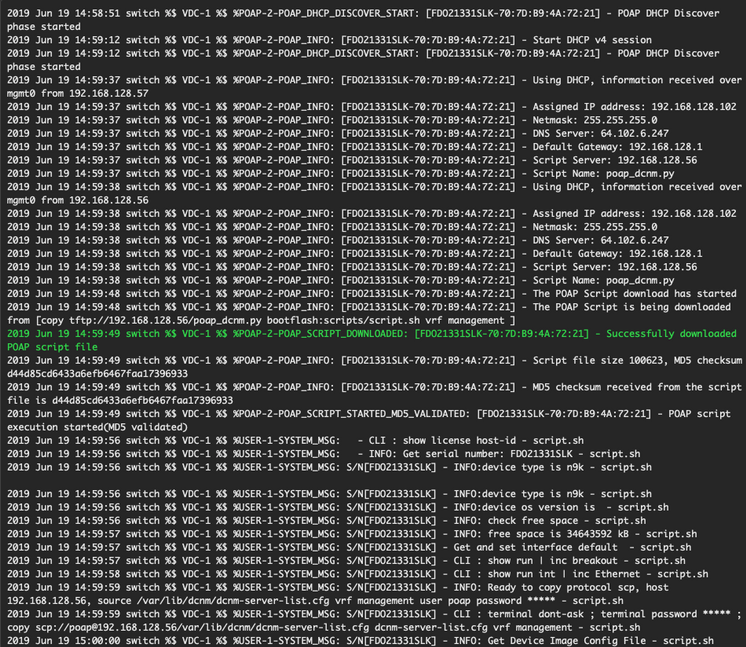

Passaggio 2. Dopo aver individuato gli switch di proprio interesse, immettere l'indirizzo IP e il nome host desiderati da utilizzare con DCNM, immettere Admin PW, quindi fare clic su Bootstrap, come mostrato nell'immagine.

Un log di avvio corretto dovrebbe apparire come mostrato nell'immagine dalla console dello switch.

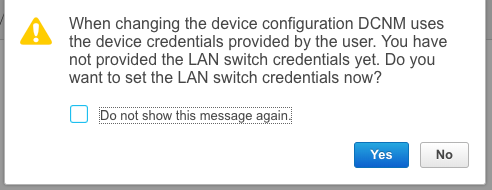

Passaggio 3. Prima di distribuire la configurazione per l'intera infrastruttura, verificare di aver configurato in precedenza DCNM con le credenziali del dispositivo. All'accesso, sulla GUI dovrebbe essere visualizzato un popup. In caso contrario, è sempre possibile accedervi tramite Amministrazione > Gestione credenziali > Credenziali LAN.

Nota: Se mancano le credenziali del dispositivo, DCNM non riesce a eseguire il push della configurazione agli switch.

Distribuire la configurazione del fabric

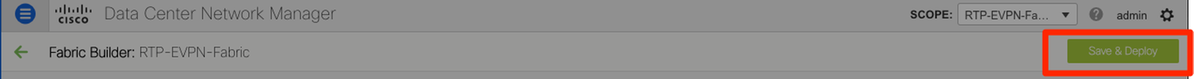

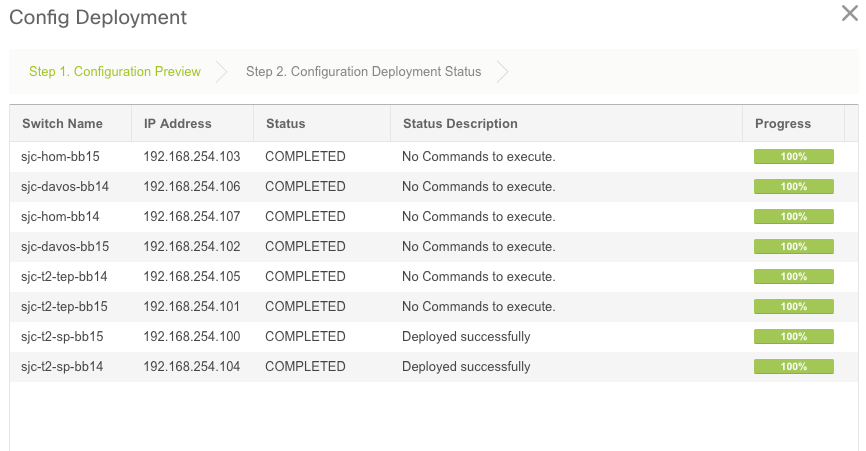

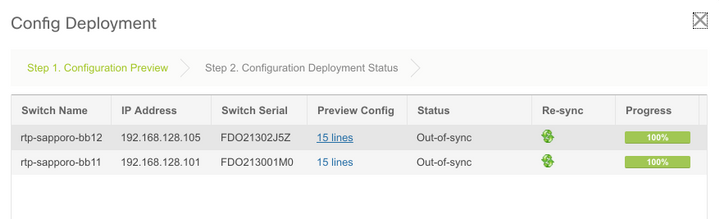

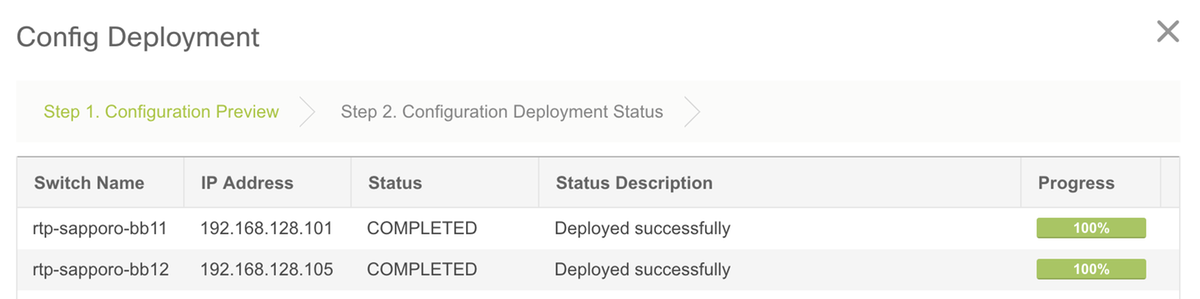

Passaggio 1. Dopo aver individuato tutti gli switch per il fabric specificato seguendo gli stessi passaggi, selezionare Controllo > Fabric > Fabric Builder > <fabric selezionato>. Visualizzare gli switch e i relativi collegamenti qui. Fare clic su Salva e distribuisci.

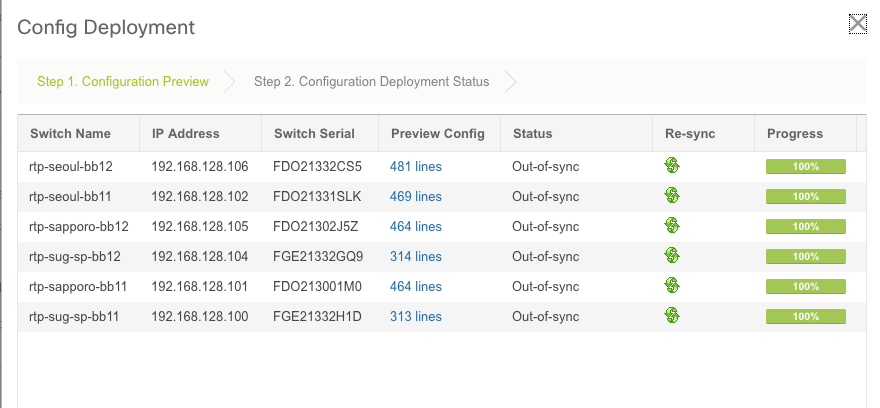

Passaggio 2. Nella finestra Config Deployment (Distribuzione configurazione), è possibile visualizzare il numero di linee di configurazione per ciascun push DCNM dello switch. Se lo si desidera, è possibile visualizzare in anteprima la configurazione e confrontare prima e dopo:

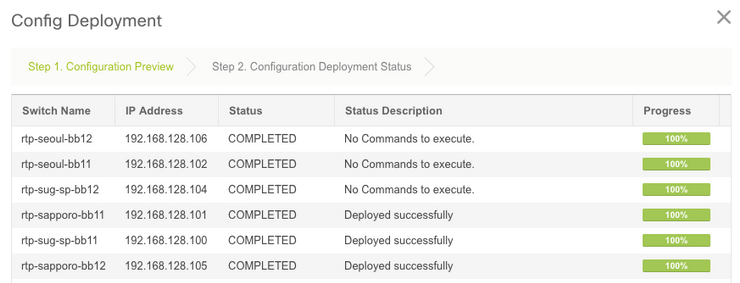

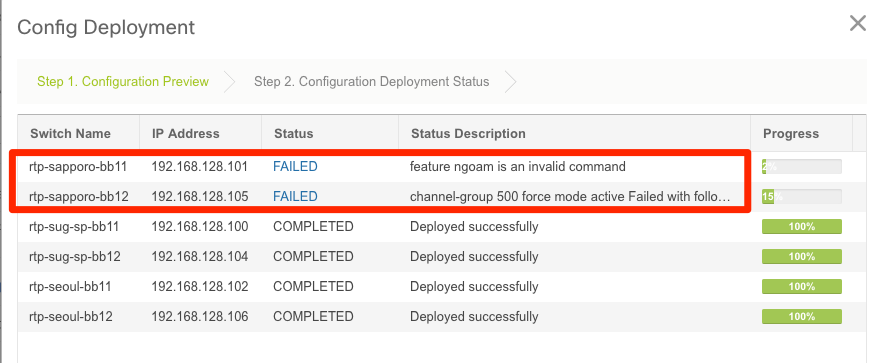

Verificare che lo stato di tutti gli switch sia COMPLETED e 100% senza errori. In caso di errori, risolverli uno alla volta (per esempi, vedere la sezione Problemi rilevati durante la distribuzione)

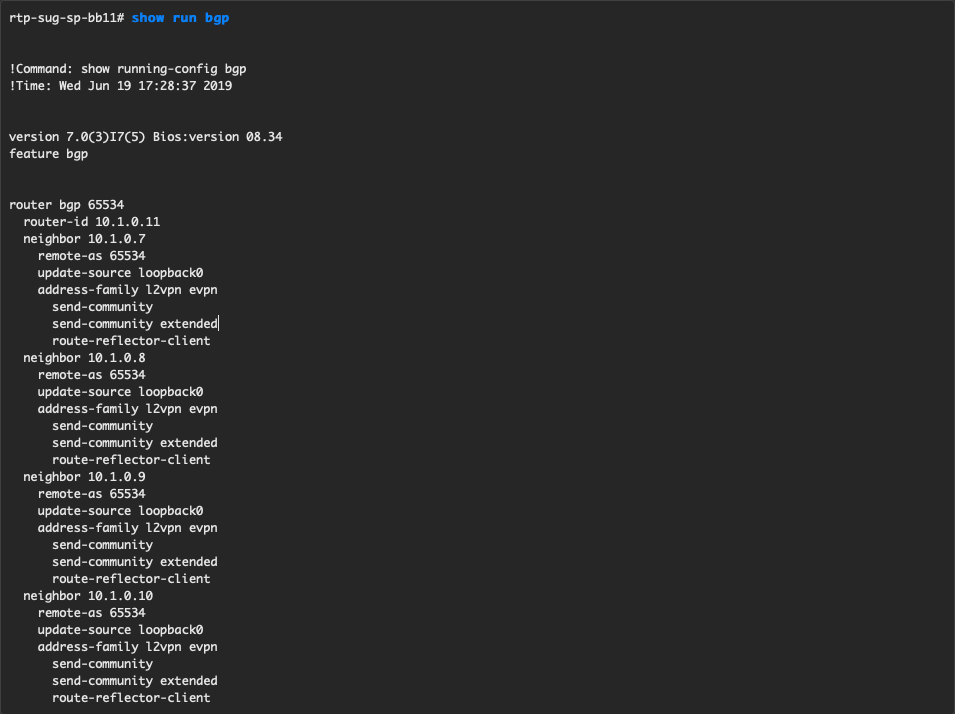

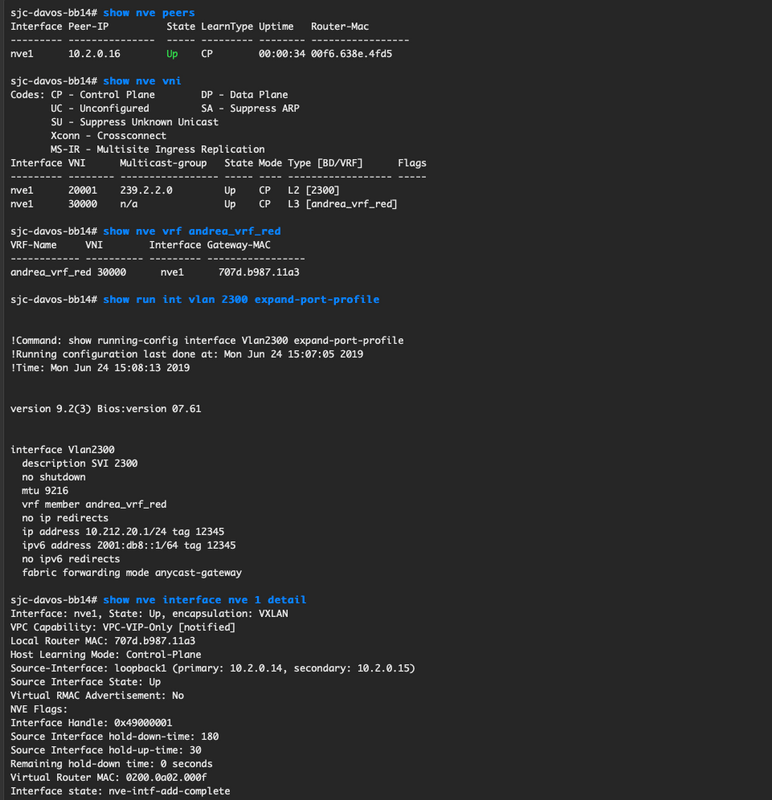

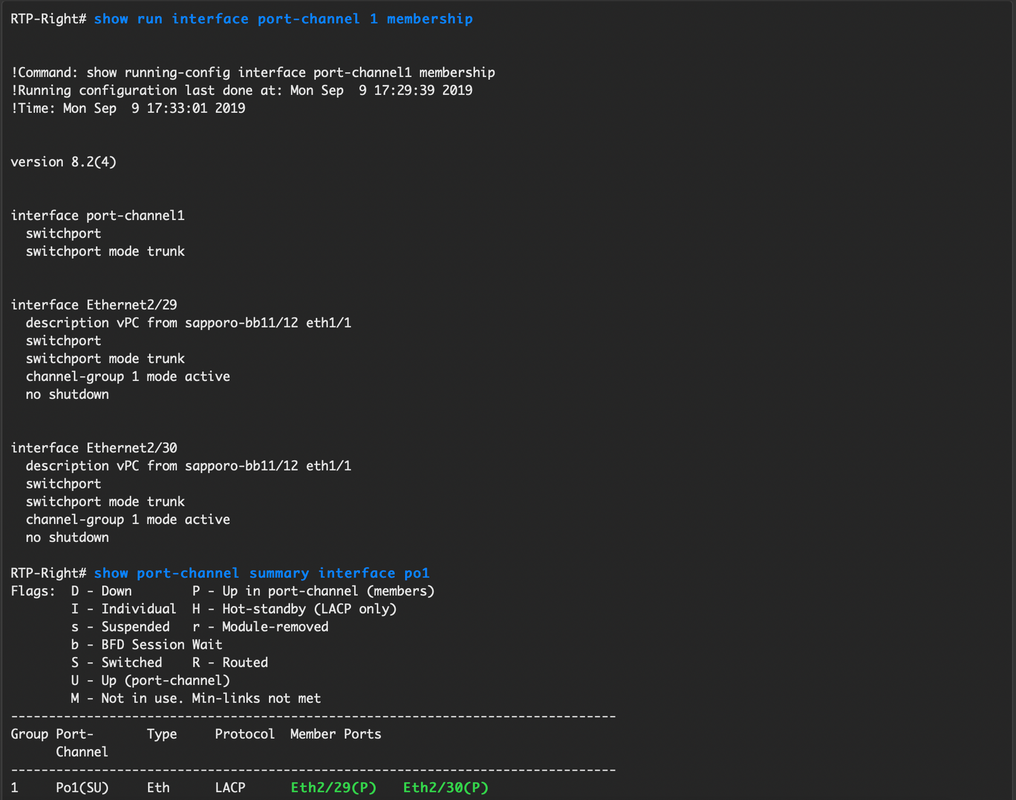

Passaggio 3. (Facoltativo) A questo punto, è possibile accedere ai dispositivi e usare qualsiasi comando show run CLI per verificare che la configurazione sia stata sottoposta a push da DCNM.

Esempio:

Implementazione del secondo fabric - SJ

Eseguire la stessa procedura descritta in precedenza per il fabric RTP utilizzando valori diversi per BGP AS, ecc.

Passaggio 1. Passare a Controllo > Fabric > Fabric Builder > Crea fabric > Denominalo!

In questa sezione vengono descritte tutte le impostazioni di sovrapposizione, sovrapposizione, vPC, replica e così via necessarie. Ciò dipende dallo schema di indirizzamento della rete, dai requisiti, ecc.

Nota: Se si utilizza un sistema multisito, l'indirizzo MAC di Anycast Gateway deve corrispondere all'altro fabric. Successivamente, non saranno supportati altri MAC di Anycast Gateway. Questo è stato corretto in seguito durante la sezione Distribuzione su più siti (non mostrata nell'articolo per brevità).

Passaggio 2. Configurare la sezione Bootstrap come descritto in precedenza. Spostarsi di nuovo tra Aggiungi switch. Una volta individuate tutte le configurazioni, fare clic su Salva e distribuisci per distribuirle. Tutto questo è stato trattato nella sezione RTP Fabric Deployment (omessa qui per brevità).

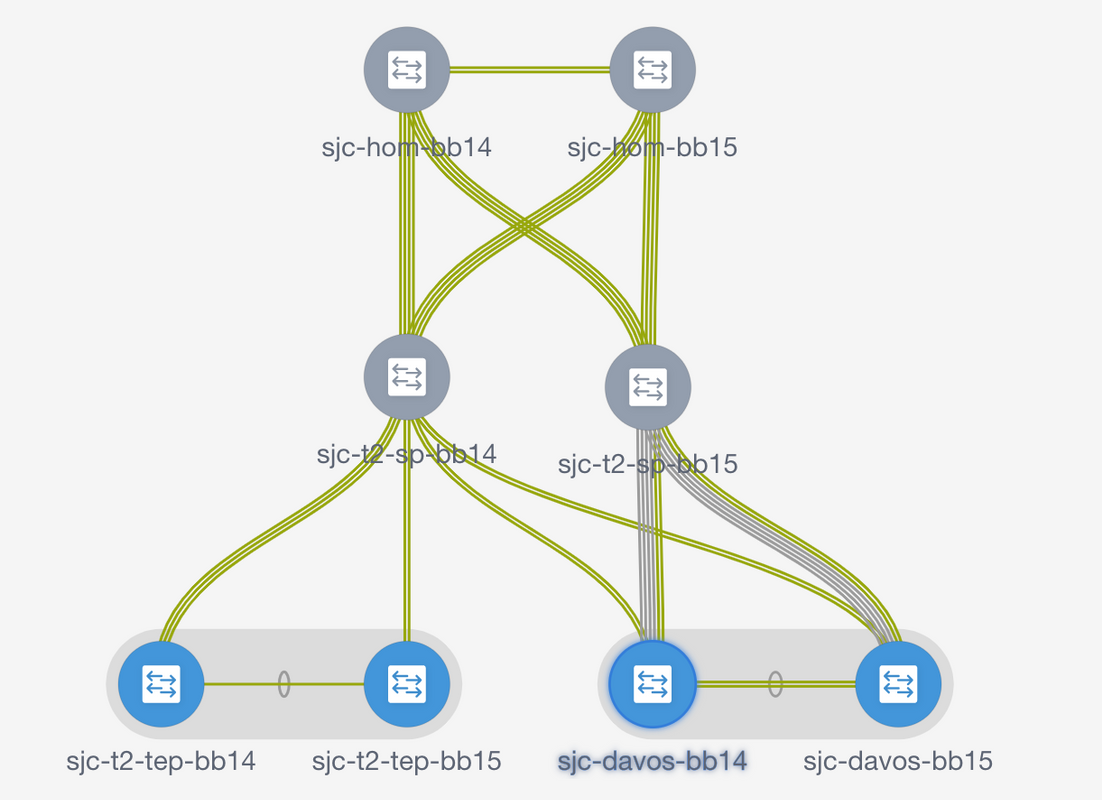

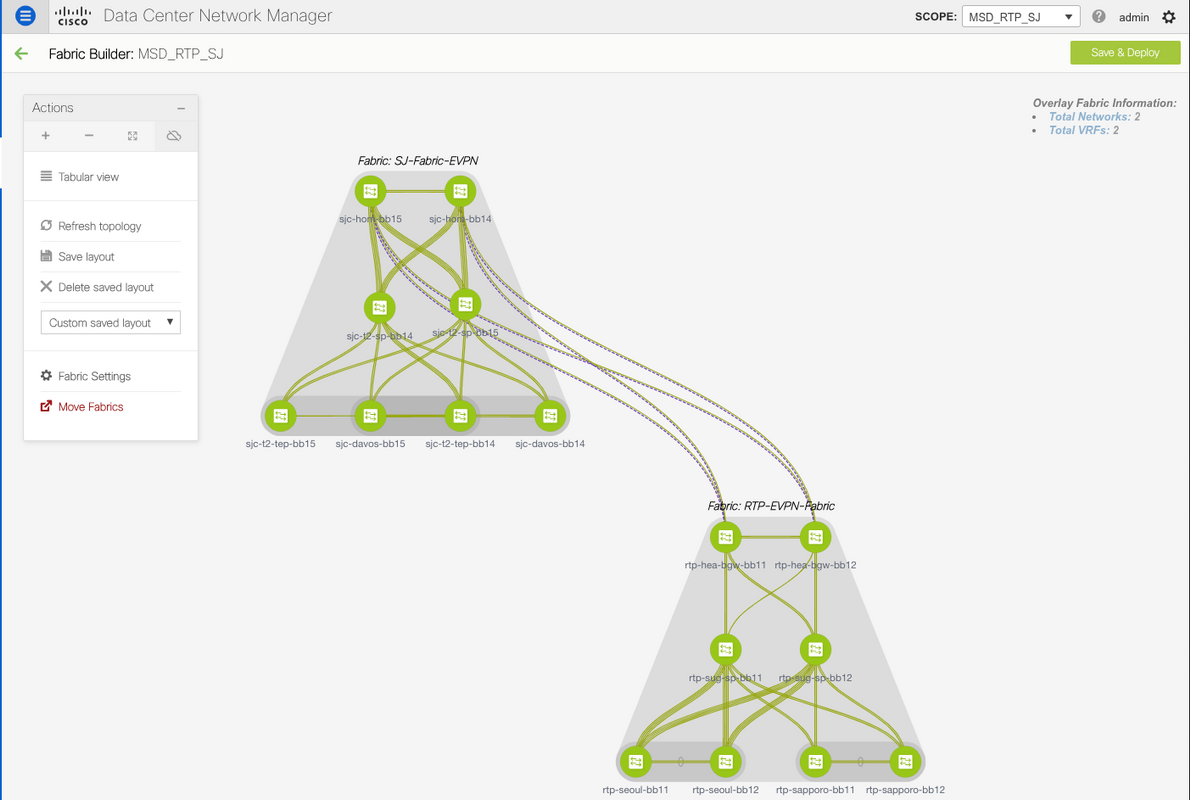

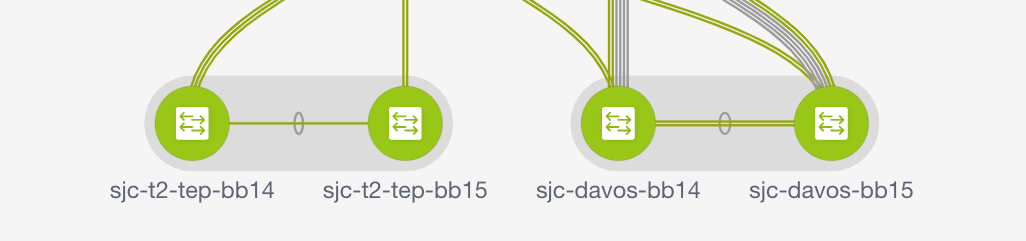

Topologia dal punto di vista di Fabric Builder alla fine.

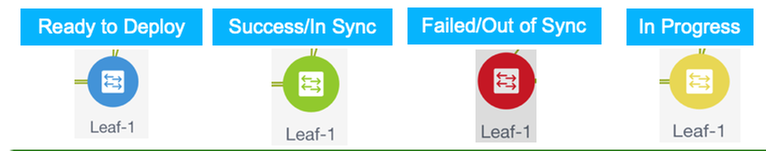

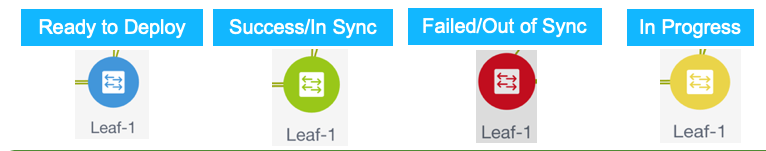

In teoria, tutti gli switch dovrebbero essere visualizzati in verde con i relativi collegamenti. Questa immagine mostra i diversi colori di stato nella media DCNM.

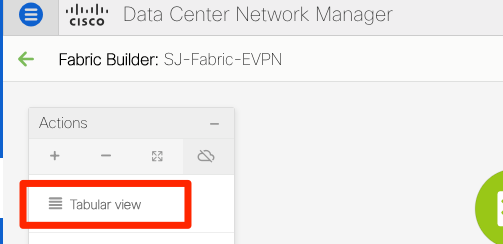

Passaggio 3. Una volta configurati e installati entrambi i fabric, assicurarsi di salvare la configurazione e il ricaricamento per rendere effettive le modifiche TCAM. Andare a Controlli > Fabric > Fabric Builder > <fabric>, quindi passare alla vista tabulare, come mostrato nell'immagine.

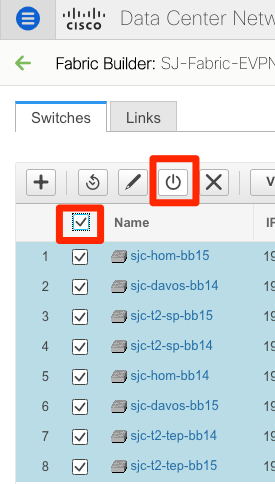

Passaggio 4. Quindi, fare clic sul pulsante di alimentazione (questo comando ricarica tutti gli switch contemporaneamente):

Creazione di una rete (VLAN/L2VNI) e di VRF (L3VNI)

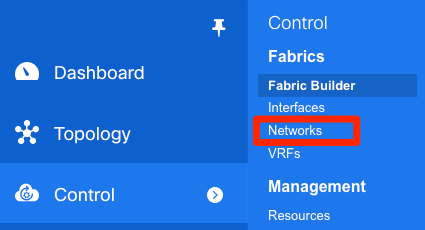

Passaggio 1. Passare a Controllo > Fabric > Reti, come mostrato nell'immagine.

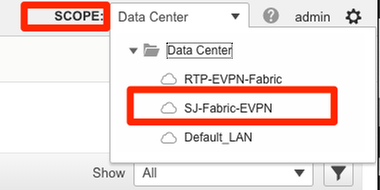

Passaggio 2. Come mostrato nell'immagine, selezionare l'ambito per la modifica. Ad esempio, a quale fabric deve essere applicata questa configurazione?

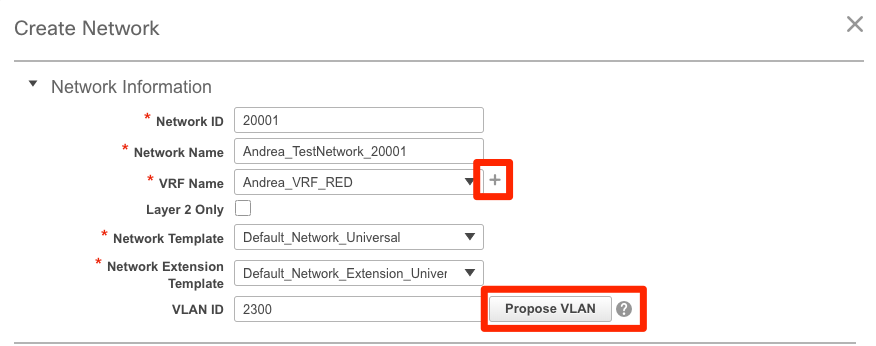

Passaggio 3. Fare clic sul segno +, come mostrato nell'immagine.

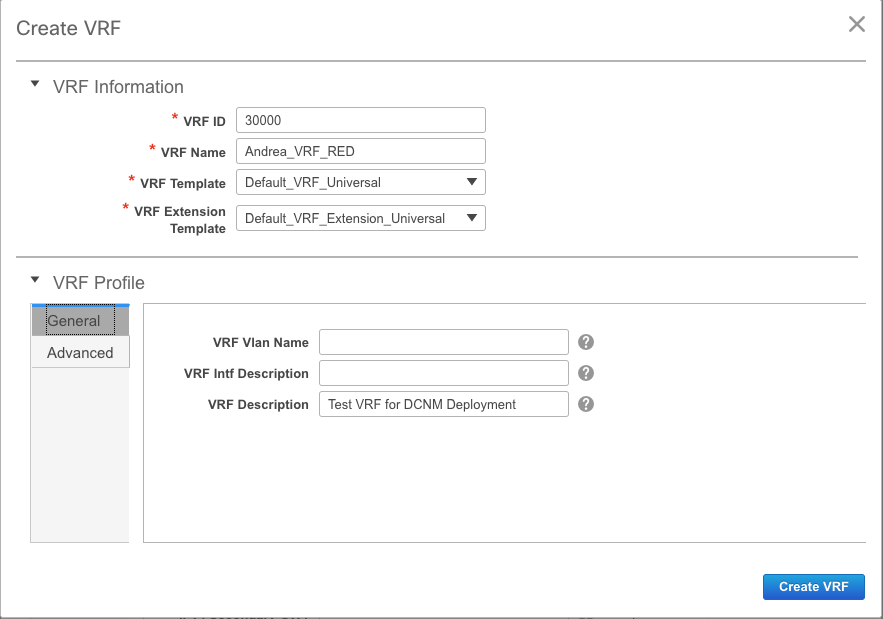

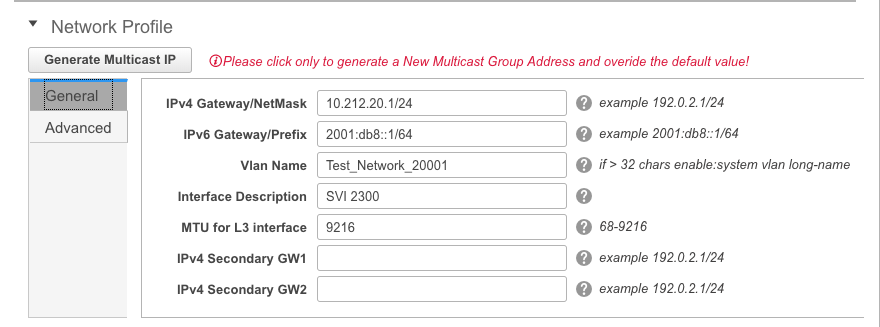

Passaggio 4. DCNM assiste l'utente durante il processo di creazione dell'interfaccia virtuale dello switch (SVI) (o della VLAN L2 pura). Se in questa fase non viene creato alcun VRF, fare di nuovo clic sul pulsante + per passare temporaneamente alla procedura dettagliata VRF prima di procedere con le impostazioni SVI.

Queste funzioni possono essere configurate nella scheda Avanzate:

- Soppressione ARP

- Replica in ingresso

- Gruppo Multicast

- DCHP

- Tag route

- TRM

- Route-Target VNI L2

- Abilita gateway L3 al bordo

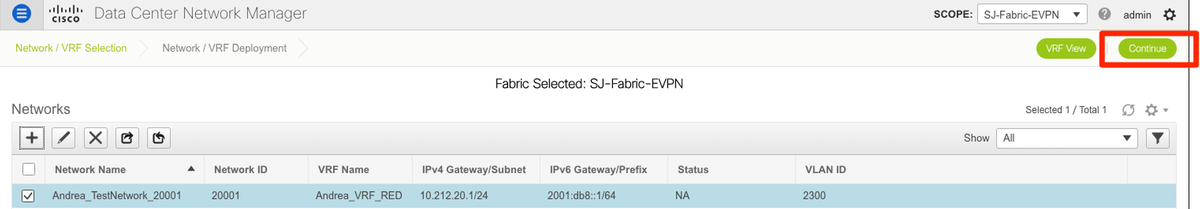

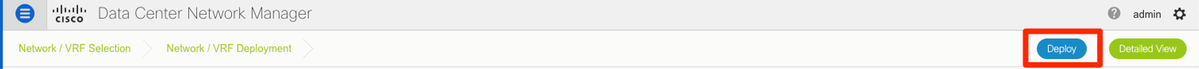

Passaggio 5. Fare clic su Continue (Continua) per distribuire la configurazione Network/VRF.

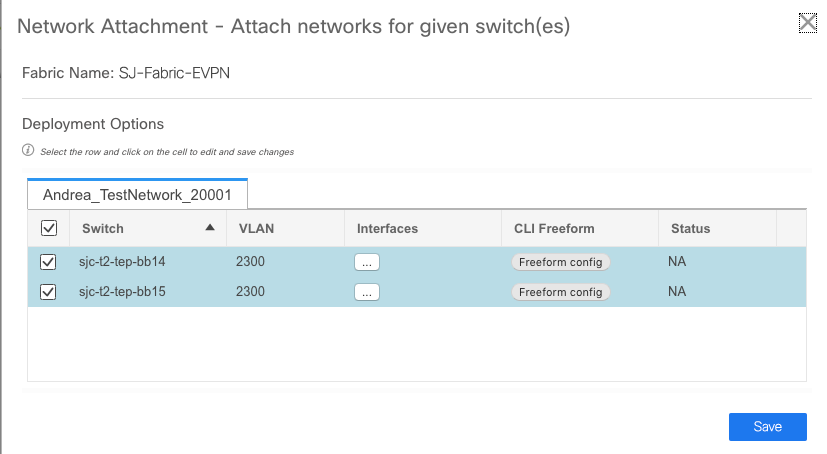

Passaggio 6. Fare doppio clic su uno o più dispositivi nella visualizzazione della topologia (DCNM li visualizza automaticamente qui) per selezionarli per la configurazione applicabile. Fare clic su Save (Salva), come mostrato nell'immagine.

Passaggio 7. Una volta selezionati, gli switch dovrebbero apparire blu (pronti per la distribuzione), come mostrato in questa immagine.

Nota: se si desidera verificare la configurazione per la CLI prima della distribuzione, è possibile fare clic su Vista dettagliata invece di Distribuisci e fare clic su Anteprima nella schermata successiva.

Quando la configurazione è applicata, gli switch diventano gialli e al termine tornano al verde.

Passaggio 8. (Facoltativo) È possibile accedere alla CLI per verificare la configurazione, se necessario (ricordare di utilizzare l'opzione expand-port-profile):

Configurazione multisito

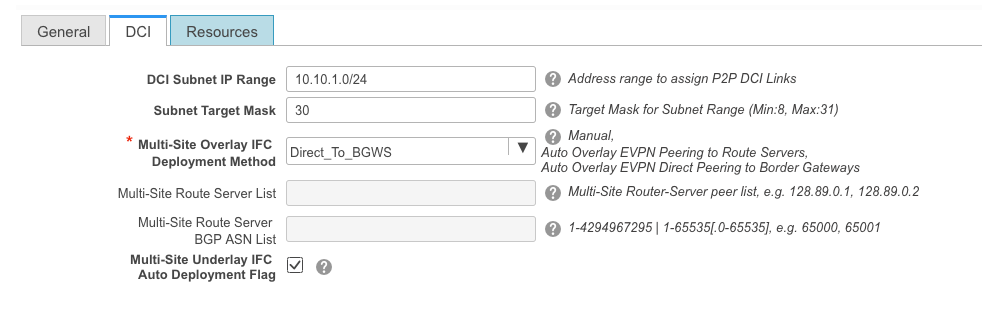

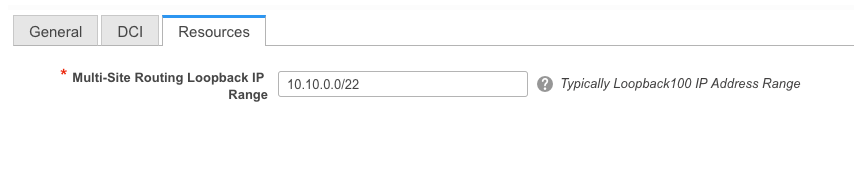

Per questa implementazione di Greenfield, l'infrastruttura MSD viene distribuita tramite peer diretto tra Border Gateway (BGW). In alternativa è possibile utilizzare un server di routing centralizzato, non descritto nel presente documento.

Passaggio 1. Passare a Controllo > Fabric Builder > Crea fabric, come mostrato nell'immagine.

Passaggio 2. Assegnare un nome all'infrastruttura multisito e scegliere MSD_Fabric_11_1 nell'elenco a discesa per il modello di infrastruttura.

Passaggio 3. In Generale, verificare che l'intervallo VNI L2 e L3 corrisponda a quello utilizzato dai singoli fabric. Inoltre, l'indirizzo MAC del gateway Anycast deve corrispondere su entrambi i fabric (nell'esempio, RTP/SJ). DCNM restituisce un errore se gli MAC del gateway non corrispondono e devono essere corretti prima di procedere con la distribuzione MSD.

Passaggio 4. Fare clic su Save, quindi selezionare MSD Fabric e fare clic su Save & Deploy. Una volta completata correttamente la topologia dovrebbe essere simile a queste (tutti gli switch + collegamenti verdi):

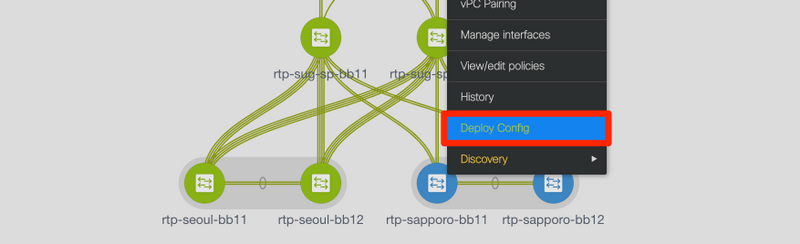

Distribuisci criteri di accesso host/trunk

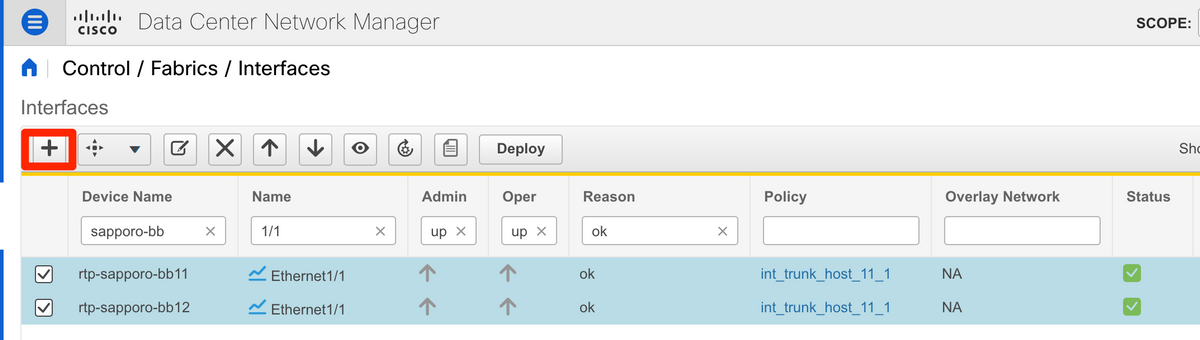

Per questo esempio, vengono configurati i trunk vPC di due diverse coppie VTEP e viene verificata la connettività all'interno del fabric RTP locale. Topologia pertinente, come mostrato nell'immagine:

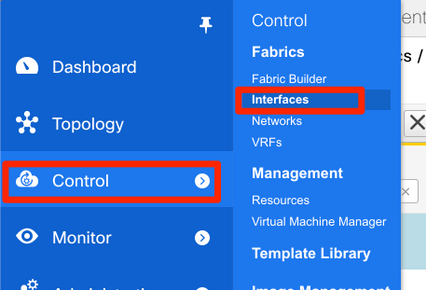

Passaggio 1. Passare a Controllo > Fabric > Interfacce, come mostrato nell'immagine.

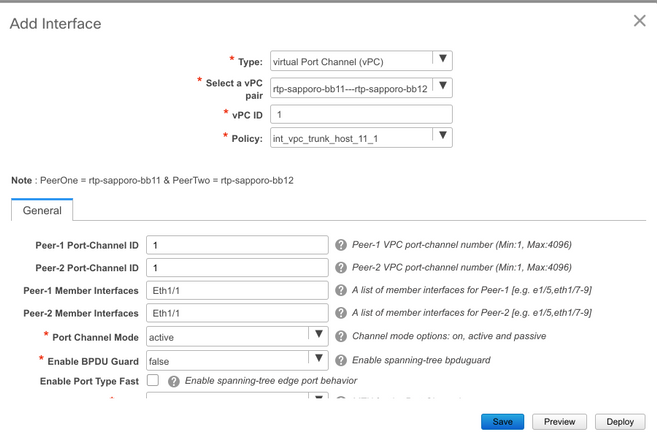

Passaggio 2. Fare clic sul segno + per accedere alla procedura guidata Aggiungi interfaccia, come mostrato nell'immagine.

Nell'esempio, viene creato un trunk vPC a valle del N7K, che viene utilizzato per eseguire il ping dei test in questa procedura dettagliata.

Passaggio 3. Selezionare la coppia vPC appropriata, le interfacce fisiche, l'attivazione/la disattivazione LACP, BPDUGuard e così via.

Passaggio 4. Al termine, fare clic su Save (Salva). In alternativa, è possibile distribuire direttamente, come mostrato nell'immagine.

Passaggio 5. (Facoltativo) Esaminare la configurazione da applicare.

Passaggio 6. (Facoltativo) Configurazione manuale su 7K:

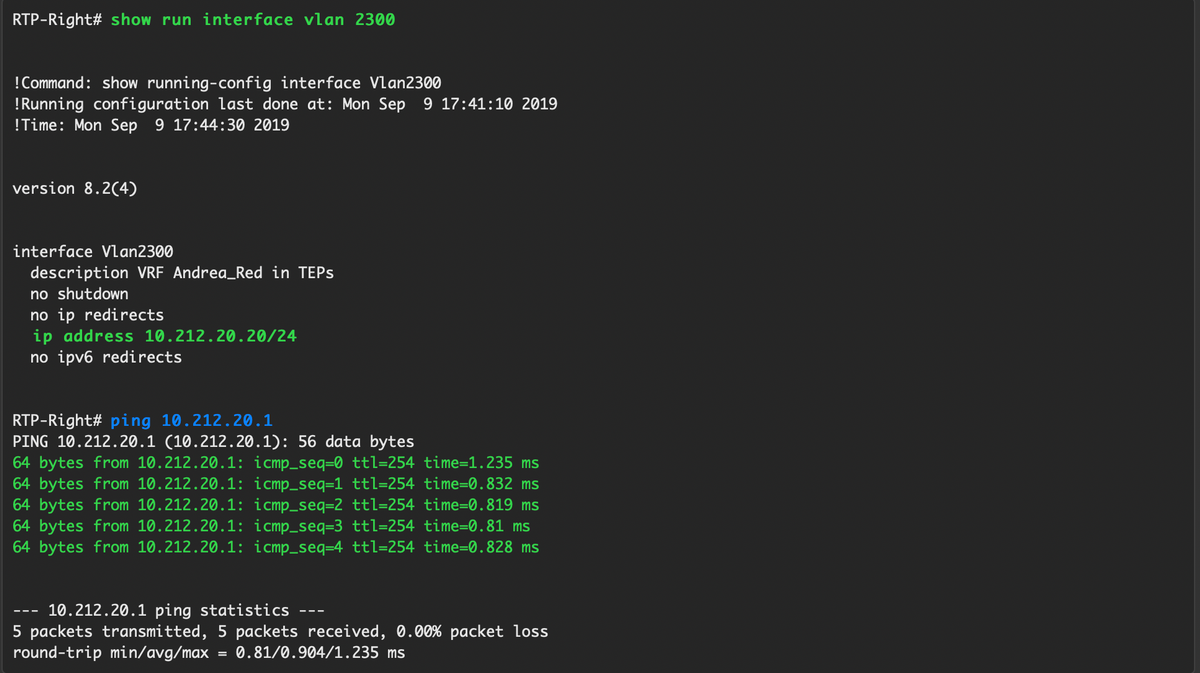

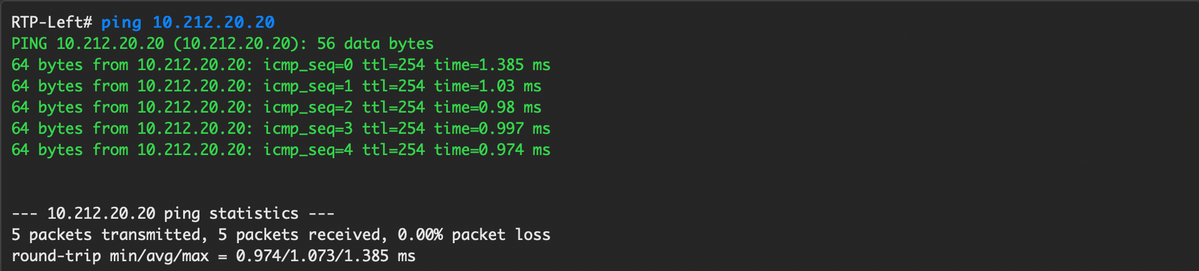

Passaggio 7.(Facoltativo) Creazione di una SVI di test su N7K per eseguire il ping dei VTEP in RTP (i VTEP hanno Anycast Gateway pari a 10.212.20.1 in VRF andrea_red):

Passaggio 8. (Facoltativo) Verificare che altri VTEP in RTP vedano questo host tramite EVPN/HMM:

Passaggio 9.(Facoltativo) Ripetere la stessa procedura per seoul-bb11/12 (creare un canale porta vPC, creare SVI 2300). Ping da RTP-Left a RTP-Right per confermare la connettività L2 su EVPN all'interno di RTP Fabric:

È possibile seguire una procedura simile per creare canali porte non vPC, interfacce di accesso, ecc. nel contesto Add Interfaces.

Operazioni Giorno 2

Aggiornamento del software NX-OS tramite DCNM

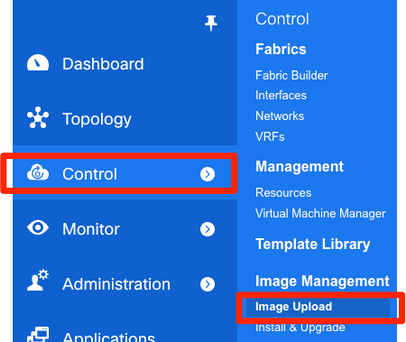

Passaggio 1. Caricare un'immagine (o un set di immagini sul server DCNM), quindi selezionare Control > Image Management > Image Upload, come mostrato nell'immagine.

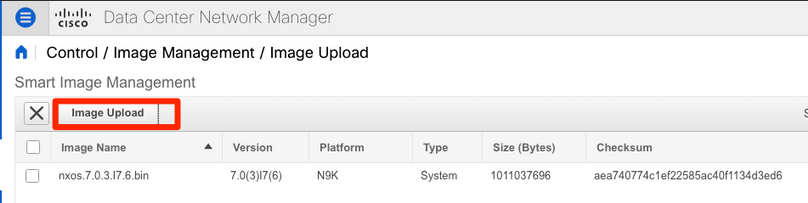

Passaggio 2. Seguire le istruzioni per il caricamento locale, quindi i file dovrebbero essere visualizzati come mostrato nella seguente immagine:

Passaggio 3. Una volta caricati i file, è possibile procedere all'installazione e all'aggiornamento se gli switch richiedono un aggiornamento. Selezionare Controllo > Gestione immagini > Installazione e aggiornamento, come mostrato nell'immagine.

Passaggio 4. Selezionare gli switch che si desidera aggiornare. Nell'esempio, viene aggiornato l'intero fabric RTP.

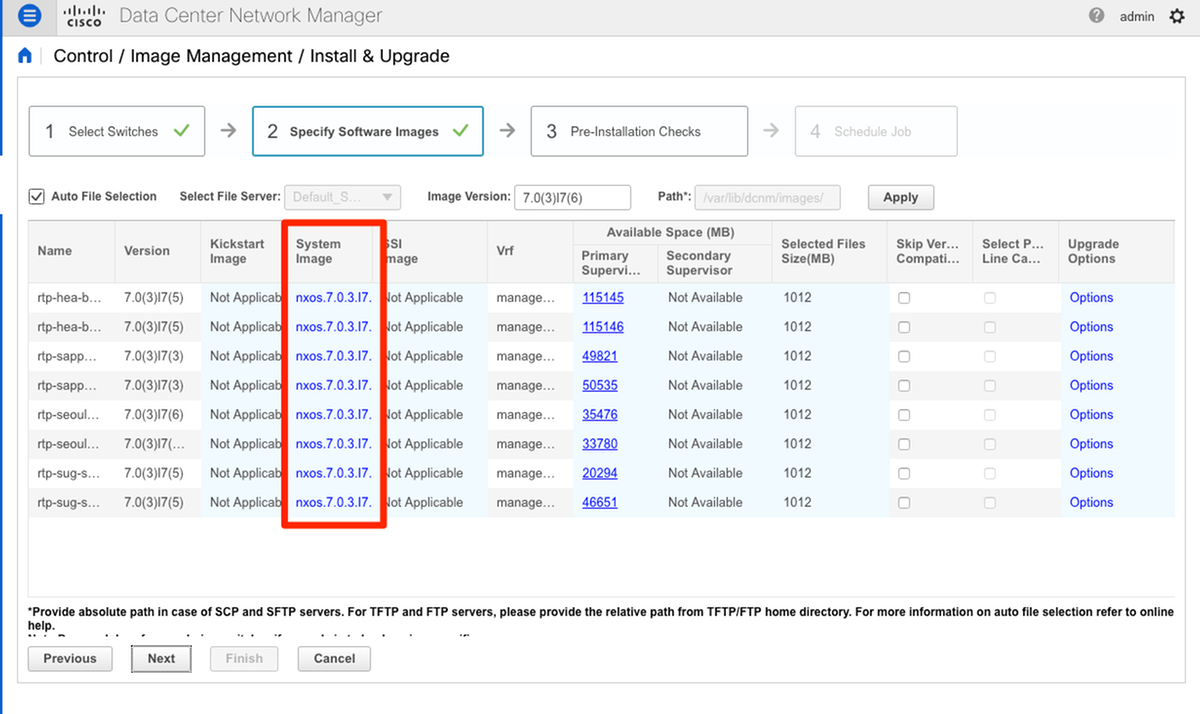

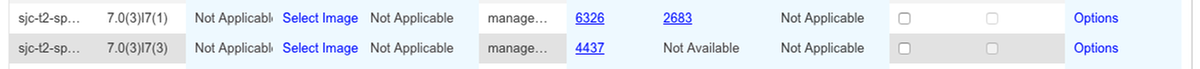

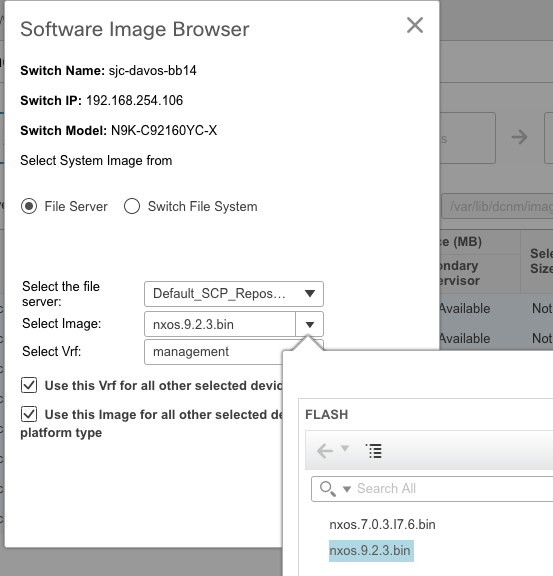

Passaggio 5. Selezionare la versione del sistema operativo NX a cui si desidera aggiornare gli switch (è buona norma aggiornare tutti gli switch alla stessa versione del sistema operativo NX):

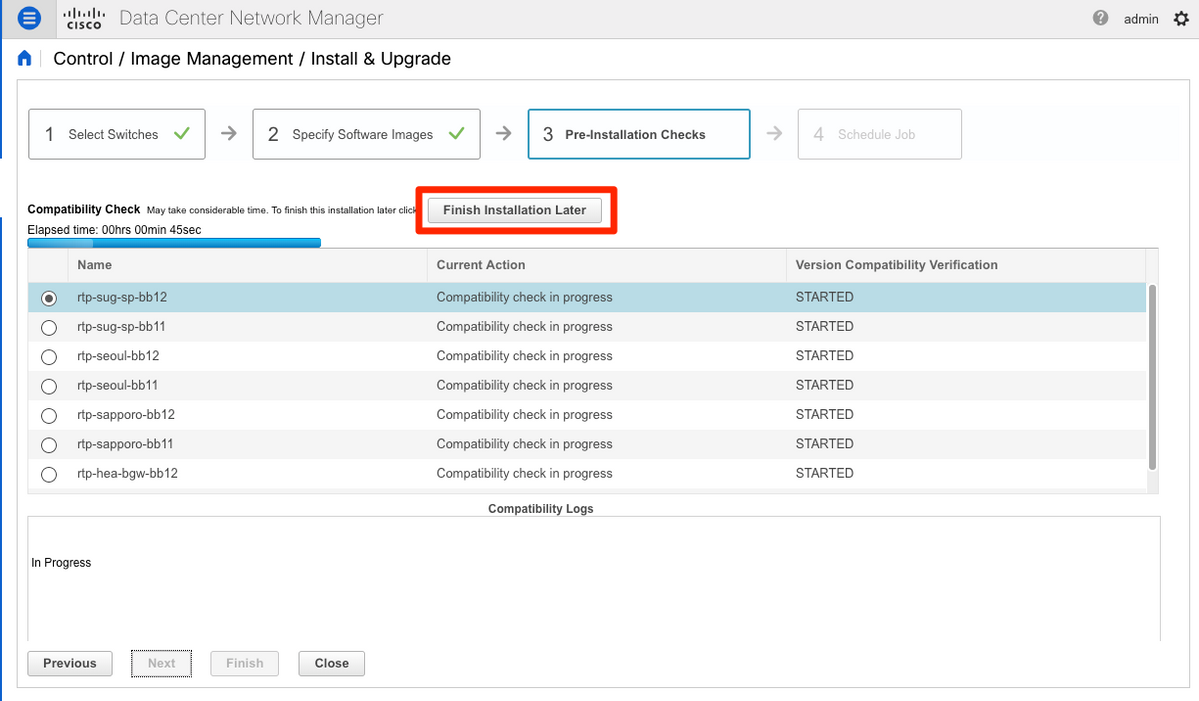

Passaggio 6. Fare clic su Next (Avanti) per eseguire DCNM sugli switch tramite controlli di preinstallazione. Questa finestra può richiedere molto tempo, quindi è possibile scegliere Termina installazione in seguito e pianificare l'aggiornamento mentre non si è al computer.

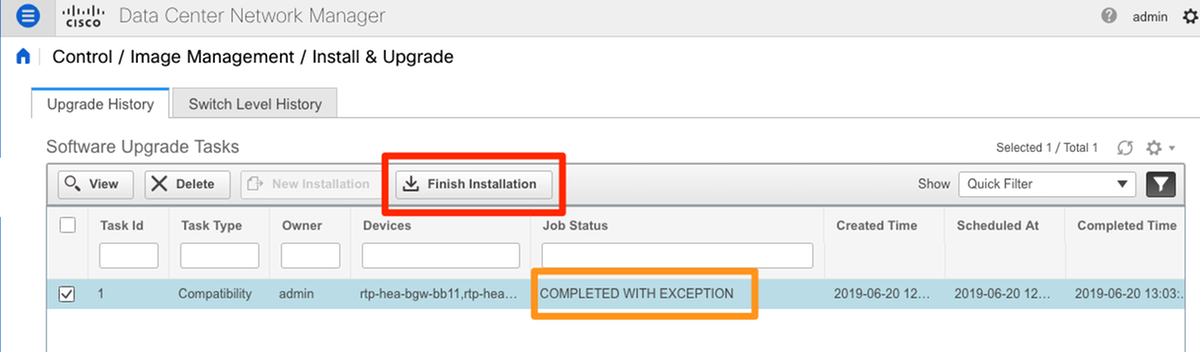

Una volta completata, l'operazione viene accodata e visualizzata come mostrato nell'immagine.

Nota: l'eccezione nel caso precedente riguarda uno degli switch RTP che non disponeva di spazio sufficiente per l'immagine NX-OS.

Passaggio 7. Una volta ottenuta la compatibilità, fare clic su Finish Installation nella stessa finestra, come mostrato nell'immagine.

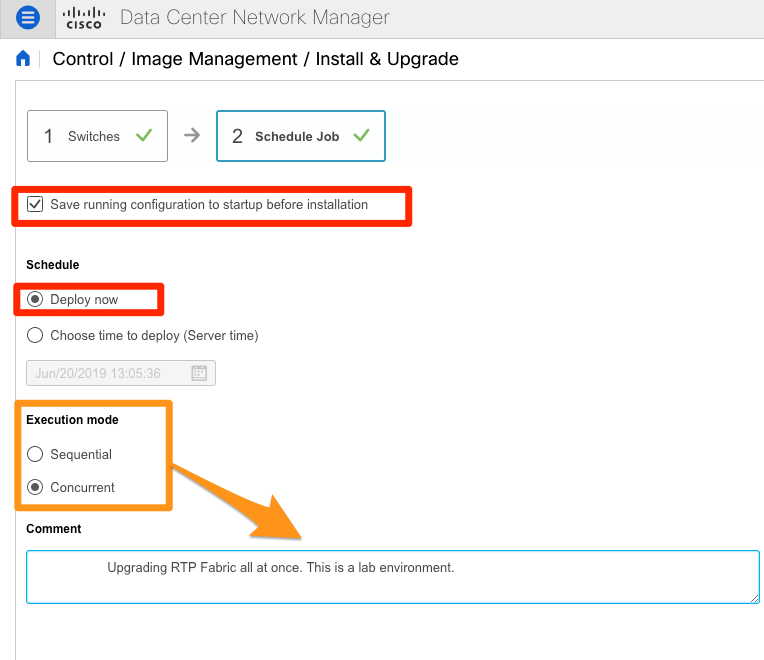

Passaggio 8. È possibile selezionare gli aggiornamenti da eseguire contemporaneamente o in sequenza. Poiché si tratta di un ambiente lab, la selezione è simultanea.

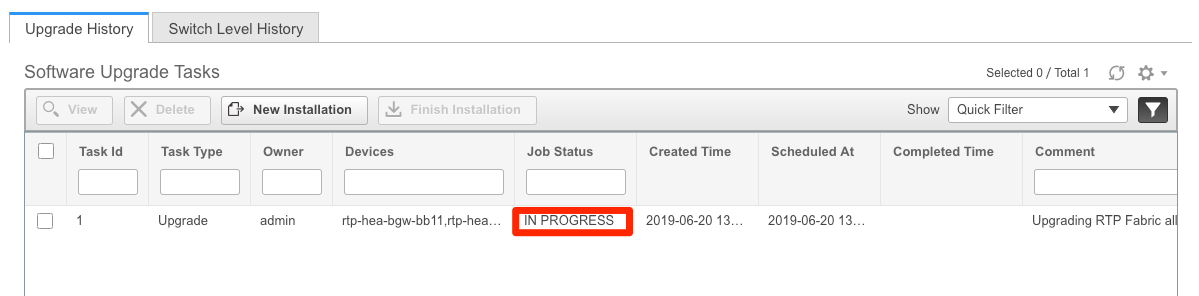

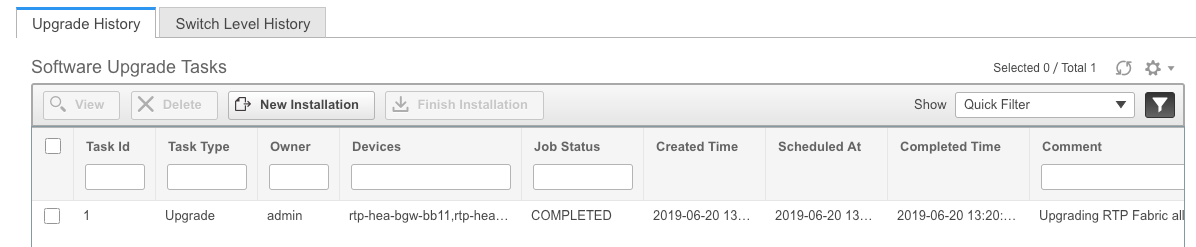

L'operazione viene creata e viene visualizzata IN CORSO, come illustrato nell'immagine.

Di seguito è riportato un modo alternativo per selezionare l'immagine.

Installa Endpoint Locator

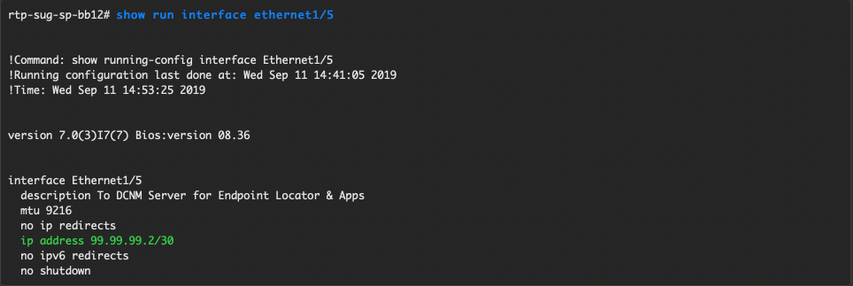

Affinché le applicazioni DCNM funzionino correttamente, è necessario disporre di connettività in banda tra il server DCNM e una porta del pannello anteriore per uno dei Nexus 9000 nel fabric. Per questo esempio, il server DCNM è collegato a Ethernet1/5 di uno degli aculei nel fabric RTP.

Passaggio 1. Questa CLI viene aggiunta manualmente a Nexus 9000:

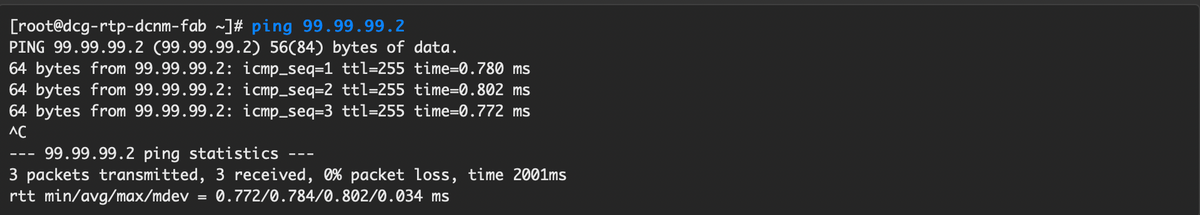

Passaggio 2. Verificare che sia possibile eseguire il ping del server DCNM e viceversa su questa connessione point-to-point.

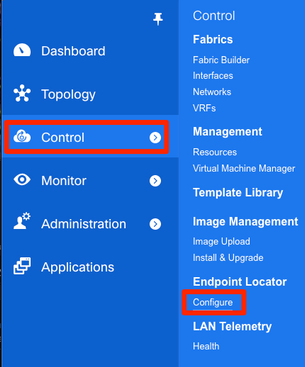

Passaggio 3. Passare alla GUI DCNM > Controllo > Localizzatore endpoint > Configura, come mostrato nell'immagine.

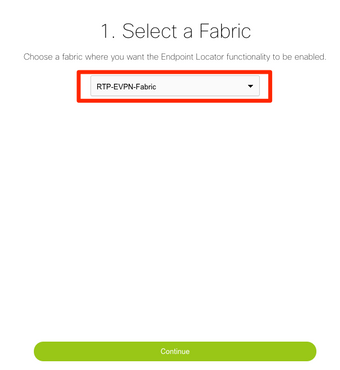

Passaggio 4. Selezionare l'infrastruttura per la quale si desidera abilitare Endpoint Locator, come mostrato nell'immagine.

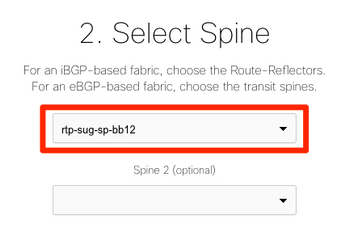

Passaggio 5. Come mostrato nell'immagine, selezionare un dorso.

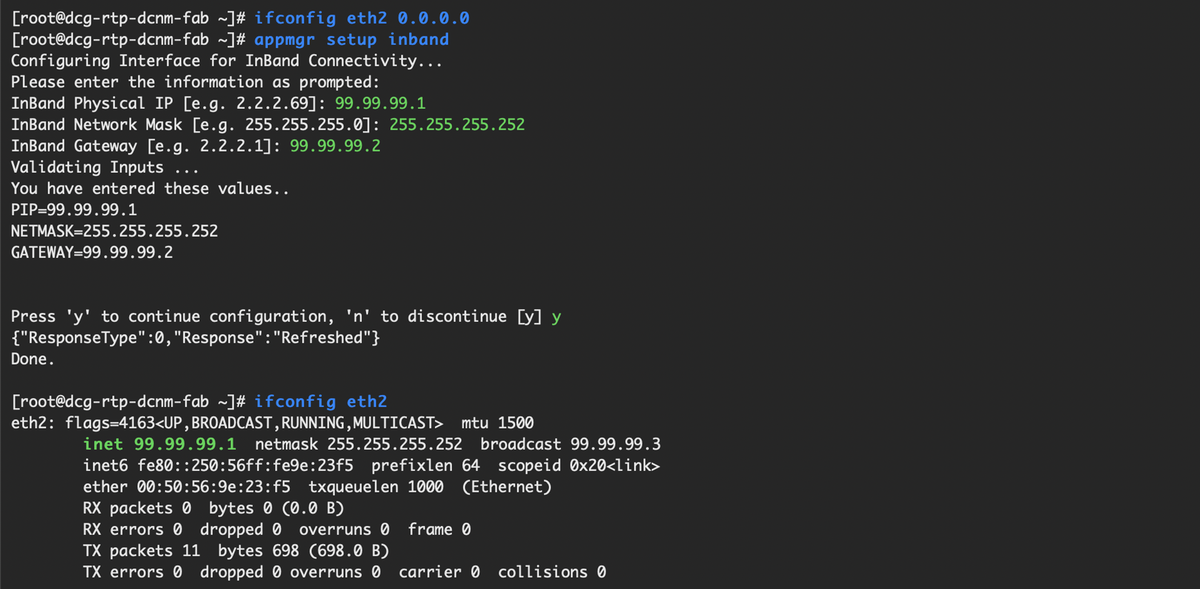

Passaggio 6. (Facoltativo). Prima di procedere al passaggio successivo, l'IP di eth2 è stato modificato rispetto all'installazione originale tramite questa CLI sul server DCNM (questo passaggio non è necessario se l'IP originale configurato durante la nuova installazione del server DCNM rimane corretto):

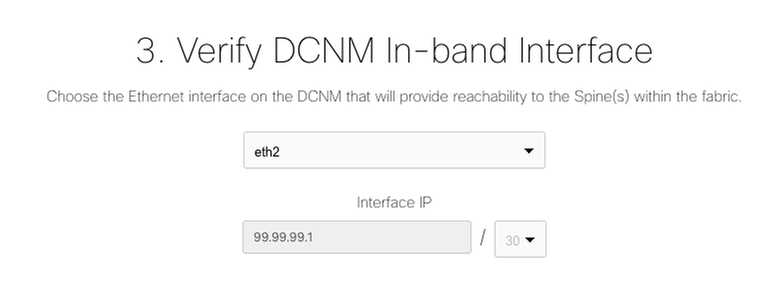

Passaggio 7. Verificare la configurazione dell'interfaccia in banda. Deve corrispondere a quanto configurato nel passaggio precedente.

Passaggio 8. Dopo aver esaminato la configurazione, fare clic su Configure (Configura). L'operazione potrebbe richiedere alcuni minuti:

Al termine, viene visualizzata la notifica, come illustrato nell'immagine.

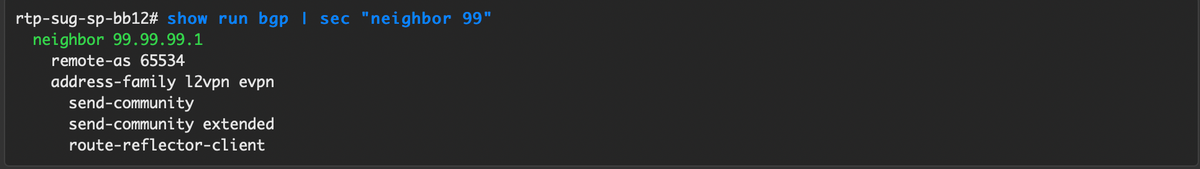

Si noti che DCNM ha configurato un router BGP adiacente sul dorso selezionato nella famiglia di VPN L2VPN.

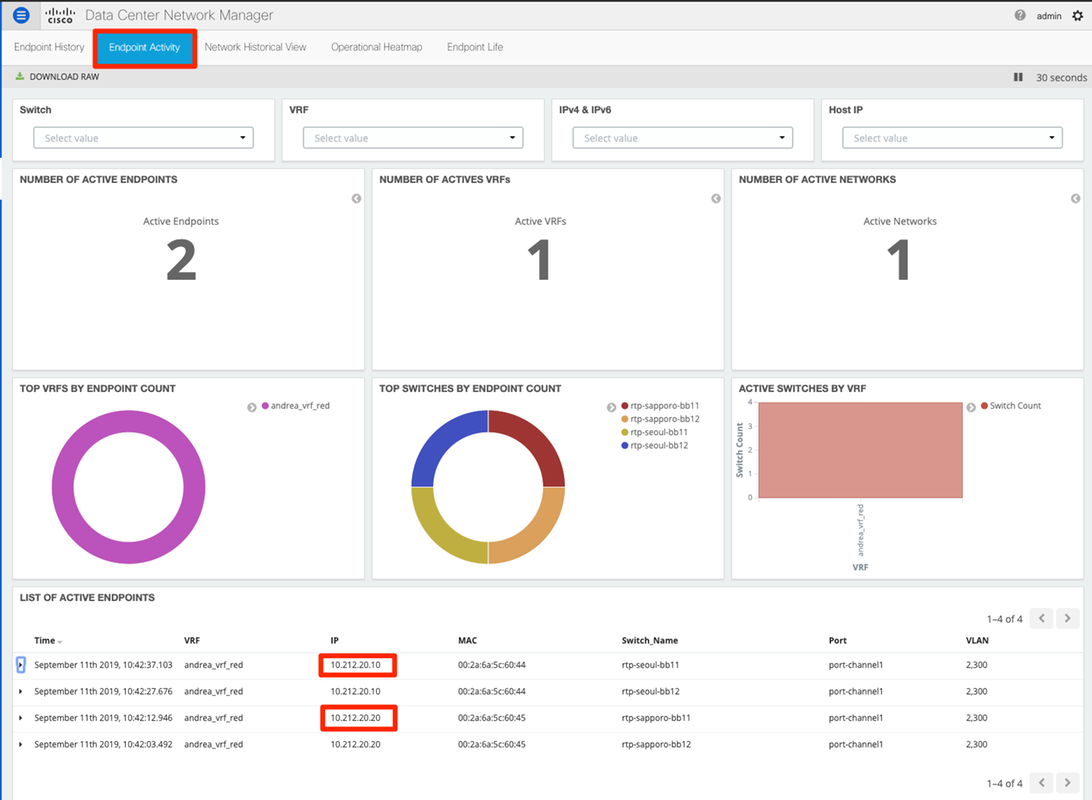

Passaggio 9. È ora possibile utilizzare la collocazione degli endpoint. Selezionare Monitor > Endpoint Locator > Esplora.

Nell'esempio, sono visibili i due host configurati per i test ping locali nell'infrastruttura RTP:

Problemi rilevati durante la distribuzione

Cablaggio non valido

Una coppia di switch aveva un cablaggio errato che ha causato un errore di bundling per vPC peer-link port-channel500. Esempio:

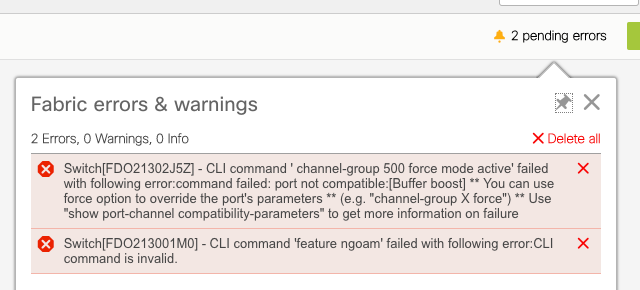

Passaggio 1. Tornare a Control > Fabric Builder ed esaminare gli errori:

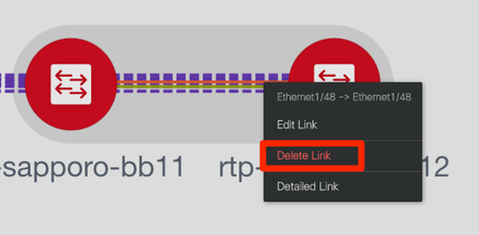

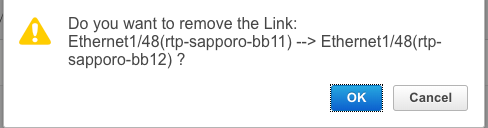

Passaggio 2. Per il primo errore relativo al comando port-channel500 con esito negativo — È stato verificato tramite show cdp neighbors che la connessione al peer vPC fosse su una porta 10G e una porta 40G (non compatibile). La porta 10G è stata rimossa fisicamente ed è stato eliminato anche il collegamento da DCNM:

Impossibile configurare una funzionalità

Per il secondo errore relativo a "feature ngoam" che non è stato possibile configurare: lo switch è stato aggiornato a una versione più recente di NX-OS in cui è supportato "feature ngoam" e fare clic di nuovo su Save & Deploy. Entrambe le questioni sono state risolte.

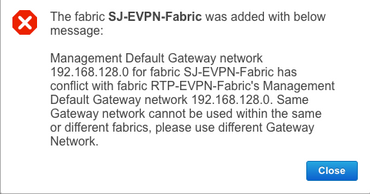

Sovrapposizione delle subnet di gestione per fabric diversi

Durante la distribuzione del secondo fabric, SJ, è stata utilizzata la stessa subnet (se fisicamente separata, dovrebbe essere corretto); tuttavia, DCNM registra un conflitto e il POAP ha esito negativo. Questa condizione viene risolta quando il fabric SJ viene inserito in una VLAN di gestione diversa e si modifica l'intervallo degli indirizzi DHCP.

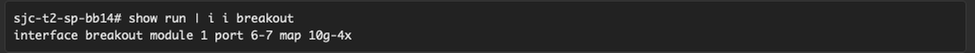

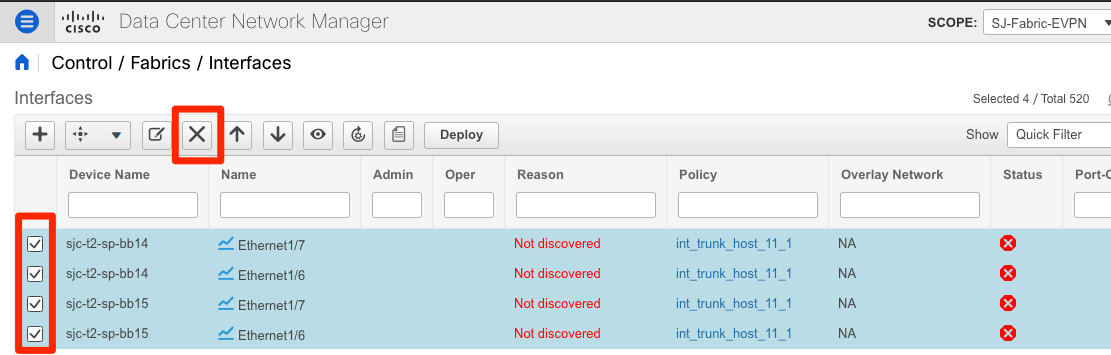

Interfacce Breakout

Passaggio 1. Per le interfacce breakout in alcuni switch (consultare la topologia), questa CLI è stata aggiunta manualmente per i T2 Spines:

Passaggio 2. Passare a Controllo > Interfacce ed eliminare le interfacce padre:

Le interfacce effettivamente utilizzate sono Eth1/6/1-4 e Eth1/7/1-4. Se non si corregge questo problema, il salvataggio e la distribuzione avranno esito negativo in seguito. C'è un modo per fare la svolta attraverso il DCNM stesso (pulsante accanto al segno +; non contemplato nel presente articolo)

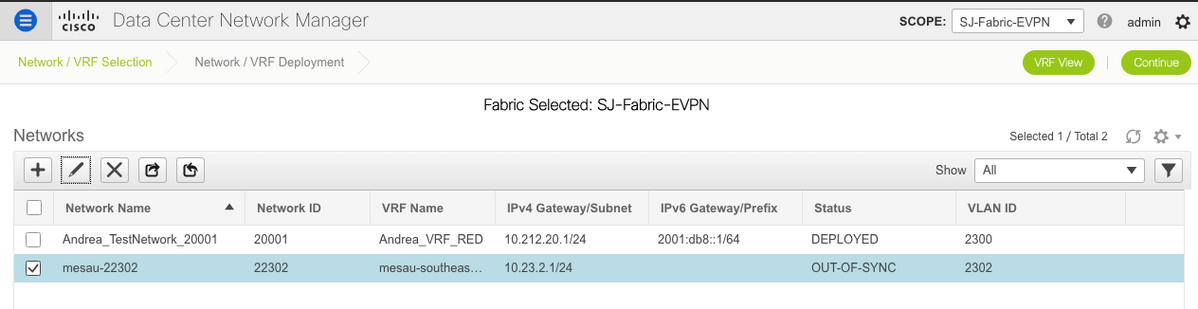

Errore di infrastruttura durante la distribuzione su funzionalità non supportate

Alcuni chassis (T2s) in SJ Fabric non supportano TRM, quindi quando DCNM ha tentato di eseguire questa configurazione, non è stato in grado di avanzare. Supporto TRM: https://www.cisco.com/c/en/us/td/docs/switches/datacenter/nexus9000/sw/92x/vxlan-92x/configuration/guide/b-cisco-nexus-9000-series-nx-os-vxlan-configuration-guide-92x/b_Cisco_Nexus_9000_Series_NX-OS_VXLAN_Configuration_Guide_9x_chapter_01001.html#concept_vw1_syb_zfb

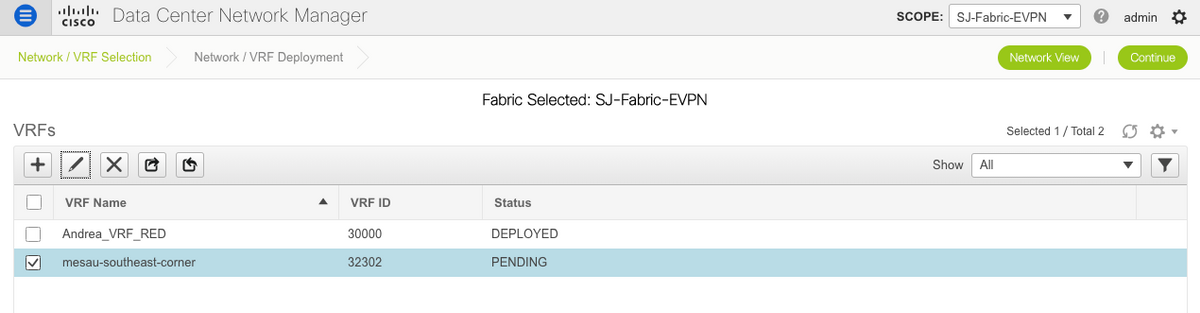

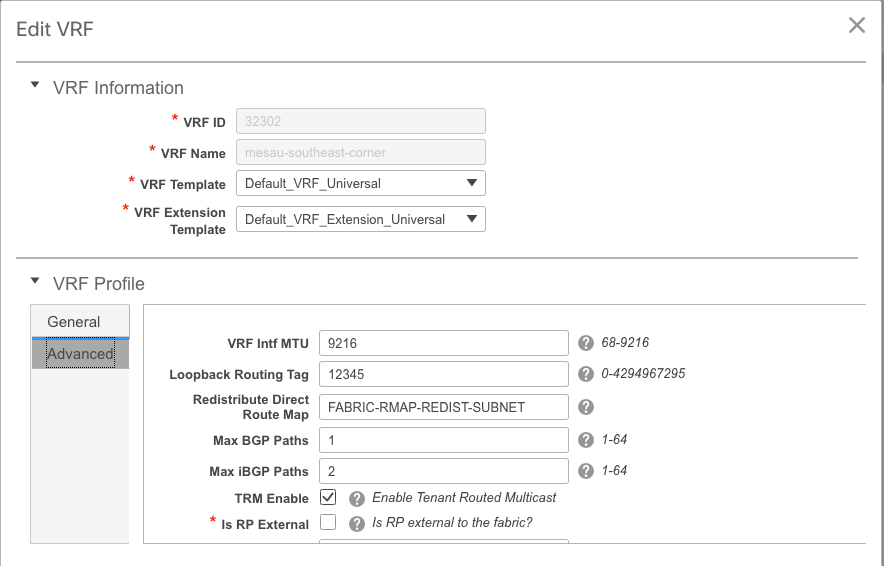

Deselezionare la casella TRM Enable (Abilita TRM) in entrambe le finestre Network (Rete) e VRF Edit (Modifica VRF).

Ripetere lo stesso processo in Controllo > Fabric Builder > VRF.

Fare clic su Continue (Continua), quindi su Deploy (Distribuisci) rispettivamente come fatto in precedenza.

Novità di DCNM 11.2

-

Peering fabric vPC

-

Fabric di routing basati su eBGP

-

Abilita EVPN all'inizio

-

-

Miglioramenti Easy Fabric Brownfield

-

Bordo dorso/Bordo dorso GW

-

PIM Bidir

-

Multicast con routing tenant

-

-

Day-0/Bootstrap con server DHCP esterno

Operazioni giorno 2:

-

Risorse di Network Insights

-

Network Insights Advisor

-

Supporto IPv6 per accesso esterno (eth0)

-

Visibilità di VMM Compute con UCS-FI

-

Miglioramenti alla vista topologia

-

Aggiornamento in linea dalla versione 11.0/11.1

Passaggio da vPC tradizionale a vPC senza MCT con DCNM:

Vantaggi di vPC senza MCT:

-

Soluzione dual-homing avanzata senza sprechi di porte fisiche

-

Conservazione delle caratteristiche tradizionali dei vPC

-

Routing ottimizzato per singoli endpoint ospitati con PIP

Informazioni correlate

- Guida alla configurazione di Cisco DCNM LAN Fabric, versione 11.2(1)

https://www.cisco.com/c/en/us/td/docs/switches/datacenter/sw/11_2_1/config_guide/lanfabric/b_dcnm_fabric_lan/control.html - Capitolo: Caso di utilizzo del provisioning dei confini in fabric VPN BGP VXLAN - multisito

https://www.cisco.com/c/en/us/td/docs/switches/datacenter/sw/11_2_1/config_guide/lanfabric/b_dcnm_fabric_lan/border-provisioning-multisite.html - White paper NextGen DCI con VXLAN EVPN Multi-Site con gateway di frontiera vPC

https://www.cisco.com/c/en/us/products/collateral/switches/nexus-9000-series-switches/whitepaper-c11-742114.html#_Toc5275096 - Capitolo: Applicazioni DCNM

https://www.cisco.com/c/en/us/td/docs/switches/datacenter/sw/11_2_1/config_guide/lanfabric/b_dcnm_fabric_lan/applications.html

Contributo dei tecnici Cisco

- Andrea TestinoCisco Engineering

Feedback

Feedback